作者简介:王晓文(1978-),女,博士研究生.研究方向:图像融合,目标跟踪.E-mail:hncandy@163.com

基于图像的不同视觉特征,构造各源图像的视觉显著图,提出一种基于视觉显著图的多尺度图像融合算法低频子带融合规则,构建了一种新的多尺度图像融合方法。结合àtrous小波和非下采样轮廓波变换(Non subsampled contourlet transform, NSCT),对多传感器图像和多聚焦图像的融合实验表明,应用本文方法所得的融合图像,无论是视觉效果还是客观评价得分均优于基于平均法或神经网络选择低频系数的融合方法。

Visual saliency maps of the source images are extracted with various image features. A novel fusion rule for the low-frequency subbands of multi-scale image fusion algorithms is proposed, and a new multi-scale image fusion method is developed based on the visual saliency maps. Átrous wavelet is integrated with Nonsubsampled Contourlet Transform, and is applied to the experiment of multi-sensor and multi-focus image fusion. It is demonstrated that the proposed approach yields better results both in visual inspection and objective evaluation than the methods choosing low frequency coefficients based on average or neural network.

图像融合的目标是把不同成像设备或不同成像模式对同一场景或同一目标获得的互补或冗余信息融入一幅图像,以便人的观察理解或进一步计算机处理。基于多尺度分解的图像融合算法是目前应用最为广泛的像素级图像融合技术,它把源图像通过多尺度变换分解成高频和低频部分,在不同频段应用不同融合规则进行选择,得到融合多尺度系数,再经多尺度反变换重构出融合图像。其中,融合规则决定着融合速度和融合图像的质量,是多尺度图像融合技术的关键[ 1]。目前对多尺度图像融合规则的研究大多集中在高频分量上,对低频分量,还没有一种有效的融合规则,多采用简单加权平均法或邻域取大法进行选择。实际上,图像经多尺度分解所得的高频部分体现着图像中点和线的奇异性,即图像中的灰度突变点或边缘等细节信息,低频部分则是原始图像的近似图像,集中了源图像的大部分能量和信息。若把多尺度分解所得的高频部分略去,只保留低频部分,然后进行多尺度反变换,仍可以恢复出大致的图像[ 2]。即图像的有用内容主要体现在其低频分量中。正确选择低频分量的融合规则,对提高融合图像的信息量,改善融合图像的视觉效果起着至关重要的作用。人类视觉系统(Human visual system,HVS)的研究表明,在观察和理解图像内容时,HVS通常对图像中的显著(更能引起视觉注意的)区域更为关注[ 3, 4],研究人员也提出了多种视觉显著性分析方法以快速检测图像中的显著区域/目标[ 5, 6, 7, 8]。图像融合领域实验也表明合理利用图像的区域特征可有效改善图像融合或融合质量评价算法的性能[ 9, 10, 11]。

本文基于文献[12]的视觉显著图(Visual saliency map)模型,结合图像的对比度、方向、亮度等多个特征,提取各源图像的视觉显著区域,并将其应用于基于àtrous小波和非下采样轮廓波变换(Nonsubsampled contourlet transform,NSCT)[ 13]的多尺度图像融合算法中,在对源图像进行多尺度分解的基础上,用视觉显著区域指导低频分量融合系数的选取,从而建立一种基于视觉显著图的图像融合新方法。

由于HVS对图像中的对比度、方向、亮度等可视特征的变化比较敏感,因而本文选用这三个特征构造视觉显著图。以两源图像 A、 B为例,按以下步骤提取源图像的视觉显著图。

第一步:分别对两源图像进行线性滤波,得到其对比度、方向、亮度特征显著图。具体实现方法如下:

(1)对比度特征图:先用高斯金字塔对源图像进行5层滤波,对滤波结果应用文献[12]中的“中心-邻域”逐层求差法得到源图像的对比度显著点分布,再对其应用文献[14]的熵阈值分割法得到源图像的对比度特征图。

(2)方向特征图:先用有向Gabor滤波器在{0°,45°,90°,135°}四个方向对源图像滤波,将滤波结果加和得到源图像的方向特征点分布,再对其应用熵阈值法分割生成方向特征图。

(3)亮度特征图:先用均值滤波器对源图像进行平滑,以消除噪声和灰度突变的影响,再对平滑后的图像直接应用熵阈值法分割生成源图像的亮度特征图。

用上述方法获得的3个特征图均为二值图像。

第二步:对第一步得到的3个单特征图求交集,(即当3个特征都标记某点为显著点时,才认为其为视觉显著点),所得结果即为两源图像的初始视觉显著区域划分,分别记作Map A和Map B。

第三步:确定最终视觉显著区域划分。若Map A∩Map B≠ ϕ(非空),则提取两源图像共有的显著区域 Spublic =Map A∩Map B。两源图像独有显著区域即为: Smap A=Map A-Spublic, Smap B=Map B-Spublic。

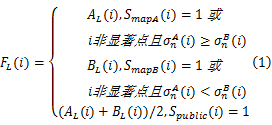

本文主要关注低频部分的融合规则。以两源图像 A、 B融合为例,在1.1节得到的视觉显著图基础上,设计低频部分的融合规则如下:

对低频图像中的每个点 i,若

(1) Smap A( i) =1,表明该点对应的区域为源图像 A的视觉显著区域,融合图像 F在该点的低频系数取源图像 A中对应点的低频系数。

(2) Smap B( i) =1,表明该点所在区域为源图像 B的视觉显著区域,融合图像 F在该点的低频系数取源图像 B中对应点的低频系数。

(3)若 Spublic( i) =1,表明该点对应区域在两源图像中都显著,为不丢失信息,取两源图像对应点低频系数的均值作为融合图像 F在该点的低频系数。

(4) i不属于任意源图像的显著区域,即 i为非显著点,则先计算两源图像的邻域方差,邻域方差越大,表示该源图像在点 i所属区域内的细节越丰富,取其对应源图像的低频系数作为融合图像 F在点 i的低频系数,即:

式中: AL( i)、 BL( i)、 FL( i)分别为两源图像和融合图像在点 i处的低频系数;

在1.1节得到的视觉显著图和1.2节设计的融合规则的基础上,本文提出一种基于视觉显著图的图像融合方法,其实现步骤如下:

(1)先对输入源图像 A、 B分别按照1.1节的方法进行处理,提取其独有视觉显著区域 Smap A、 Smap B和公共显著区域 Spublic,并计算两源图像中非显著区域的邻域方差。

(2)利用多尺度分解算法对两源图像进行多尺度分解,得到其高频分量{ AH}、{ BH}及低频分量 AL和 BL。

(3)对高频分量,采用绝对值取大法,得到融合后的高频系数{ FH}。

(4)对低频分量,按照式(1)选择融合系数 FL。

(5)对所得的融合系数进行多尺度反变换,重构出融合图像 F。

在多尺度融合算法中,àtrous小波和NSCT由于采用非下采样分解,具有平移不变性,不会导致块效应,融合效果要优于离散小波变换(DWT)、轮廓波变换(CT)等基于下采样分解的多尺度融合方法。因而,本文选用àtrous小波和NSCT这两种多尺度变换技术,采用前述基于视觉显著图的融合规则选择低频融合系数,从而建立了两种新的多尺度融合算法,分别记作S-àtrous和S-NSCT。

本节设计了两组实验,分别利用“UN Camp”红外与可见光多传感器图像和“Clock”多聚焦图像对本文方法性能进行检验,并与基于加权平均法(对应算法分别记作A-àtrous和A-NSCT)和基于脉冲耦合神经网络(PCNN,对应算法分别记作P-àtrous和P-NSCT)选取低频系数的融合方法效果进行对比[ 15]。为衡量算法的性能,用互信息(Mutual information,MI)[ 16]、边缘保持度(Edge preservation,EP)[ 17]、空间频率(Spatial frequency,SF)[ 18]以及两种基于结构相似度的指标

图1为“UN Camp”可见光和红外图像的融合结果,图2为图1(a)(b)的视觉显著图提取过程示意,图中白色部分为显著区域。表1为5个客观评价指标对各融合结果的质量打分。

| 表1 对“UN Camp”图像各融合结果的客观评价得分 Table 1 Objective evaluation scores of different fusion results with“UN Camp” input images |

观察图1中各融合模式的融合结果可以看出,图1(d)和1(g)这两个基于本文提出的低频融合规则所得的融合结果不仅红外目标明确,而且较好地保留了可见光图像中的树丛、栅栏、道路等细节信息,融合效果最好,而基于PCNN加权的融合结果(图1(e)和1(h))虽然红外目标比基于平均法的融合结果(图1(c)和1(f))明确,但图像中的环境细节却不如图1(c)和1(f)。表1中的各客观评价指标的评分结果也与上述视觉感知一致,认为基于本文融合规则的两种融合算法S-àtrous和S-NSCT融合效果最优,基于PCNN的两种算法P-àtrous和P-NSCT最差。这也表明用PCNN选取融合系数可能不太适用于夜视图像融合应用。

从表1还可看到,多尺度分解算法的选择也影响着融合图像的质量。对红外与可见光图像融合应用,尽管NSCT能够提取更多高频细节,但A-NSCT的融合效果却不如A-àtrous。而应用本文融合规则后,S-NSCT所得融合图像的主观感知效果和客观评价得分均优于A-àtrous。这表明在不改变多尺度分解算法的情况下,通过本文算法优化其低频分量的融合规则,即可有效改善多尺度算法的融合效果。对CT和MRI医学图像的融合实验也肯定了这一点(在医学图像融合应用中,A-àtrous的融合效果不如A-NSCT,但采用本文融合规则后,S-àtrous的融合效果即得到大幅提升,优于A-NSCT)。限于篇幅,对医学图像的融合实验结果没有列出。而且,由于本文在构造视觉显著区域时仅采用了较为简单的线性滤波,与多尺度算法相比,增加的耗时很小,对较为复杂的多尺度融合算法如NSCT,本步骤增加的耗时甚至可以忽略不计(对“UN Camp”源图像,显著图构造过程耗时约0.37 s,A-àtrous、P-àtrous、A-NSCT和P-NSCT算法的耗时分别为2.3、4.4、262和266 s,而S-àtrous和S-NSCT的总时耗分别为2.5 s和263 s)。

利用多聚焦图像融合检验本文方法的性能。多聚焦图像融合的目标是把两源图像中聚焦清晰的内容转移到融合图像中。由于多聚焦源图像通常是在相同光照条件下获取的,不同聚焦的成像结果亮度差异较小,即图像的亮度特征不能体现不同源图像的差异。图像聚焦部分的细节通常比离焦部分清晰得多。由于图像的梯度恰恰反映了图像的细节变化,因而在对多聚焦图像提取视觉显著图时,用梯度特征取代亮度特征更符合视觉感知。梯度特征图的提取方法如下:

先用Sobel梯度算子对源图像滤波,提取其梯度显著点,即图像中梯度变化剧烈的点、线段和轮廓,再用8邻域多数滤波法去掉孤立点,最后用文献[21]的方法找到图中所有梯度显著点的凸壳区域,以此作为源图像的梯度特征图。

得到梯度特征图后,结合源图像的对比度特征图和方向特征图,依照1.1节的第二步和第三步,构造出视觉显著图,再按照1.2节的融合规则嵌入两种多尺度算法进行融合。融合结果见图3。表2为5个客观评价指标应用于各融合结果的质量得分。为便于对比不同算法的融合效果,在图4中放大显示了图3中各融合图像的部分细节。

| 表2 对多聚焦图像各融合结果的客观评价得分 Table 2 Objective evaluation scores of different fusion results with multi-focus images |

由图3可以看出,对多聚焦图像而言,3种融合规则都能较好地体现两源图像中的聚焦部分,但观察图4中的细节则会发现,基于平均法和PCNN选择低频系数的两种融合模式,都在图像左侧边缘产生了明显赝相(见图4(a)、(c)、(d)和(f)中左侧类似纸张卷曲的纵向凸起),而基于本文融合规则的两种算法则要好得多,尤其是S-NSCT,几乎没有产生可见赝相。因而,对多聚焦图像而言,6种融合模式的融合效果由优到劣依次为:S-NSCT>S-àtrous>P-NSCT>P-àtrous>A-NSCT>A-àtrous,表2中的客观评价得分也肯定了这一判断。

以上实验表明,尽管不同融合应用对多尺度分解算法和融合规则的偏好有所差异(如红外与可见光图像采用S-àtrous融合效果最好,而多聚焦图像采用S-NSCT融合效果最好),但与基于平均法和神经网络激励的融合规则相比,本文提出的基于视觉显著图的低频融合规则,无论是对多传感器图像融合,还是多聚焦图像融合,均能有效改善多尺度图像融合算法的融合效果,在有些融合应用中,甚至能以少量的时间代价得到优于更复杂融合算法的结果。

针对多尺度图像融合算法中的低频系数选取问题,结合源图像物理特性选择多种视觉特征,构造了一种基于视觉显著图的低频系数融合规则,建立了一种基于视觉显著图的多尺度图像融合方法,有效改善了多传感器/多聚焦图像的融合效果。值得注意的是,在选取构造源图像视觉显著图所用的视觉特征时,需要结合源图像的物理特性合理选取,以得到符合视觉感知的显著区域划分。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|