作者简介:陈广秋(1977-),男,博士研究生.研究方向:图像配准与融合.E-mail:guangqiu_chen@126.com

为了提升多源图像融合精度,提出了一种有限离散剪切波(FDST)域结合图像区域客观评价的自适应融合方法。该方法利用有限离散剪切波(FDST)对源图像进行多尺度、多方向分解,低频子带图像采用梯度信息相关性因子作为系数权值,高频子带图像应用绝对值与区域标准差一致性选择的融合策略。应用有限离散剪切波逆变换重构图像,采用多组多源图像进行融合试验,并对融合结果进行了客观评价。试验结果表明,本文提出的融合方法在主观和客观评价上均优于其他多尺度分解(MSD)融合方法。

To enhance the accuracy of multi-source image fusion, an adaptive fusion method is proposed. This method is based on the area objective assessment in Finite Discrete Shearlet Transform (FDST) domain. The source images are decomposed to subband images with multi-scale and multi-direction by FDST. The gradient information correlation factor is taken as the coefficient weight for low-frequency subband fusion; while for high-frequency subband, consistency selection of the coefficient absolute value and area standard deviation is adopted as the fusion rule. The fused low and high frequency coefficients are reconstructed to image by Finite Discrete Shearlet Inverse Transform (FDSIT). Fusion experiment is done with several sets of different modality images, and objective performance assessments of the fusion results are implemented. Results indicate that the proposed method performs better in subjective and objective assessments than other existing Multi-Scale Decomposition (MSD) fusion techniques.

多尺度融合方法要解决两个核心问题:一是源图像的分解;二是分解后的子带图像的融合。对于第一个问题,离散小波变换(DWT)因其所具有空频域分析图像的能力而得到广泛应用[ 1, 2]。但小波变换不能最优地表示图像结构中的直线或曲线的奇异性。为了解决小波变换的局限性,研究者先后提出了Curvelet[ 3]和Contourlet变换[ 4],这两种变换具有很好的方向敏感性和各向异性,能够准确地捕获图像中的边缘信息,取得了良好得融合效果[ 5, 6, 7, 8]。但这两种MSD方法都缺乏平移不变性,在融合结果中容易引入虚假信息,对光谱差异较大或配准精度不高的图像进行融合的过程中,伪Gibbs现象明显。文献[9]通过尺度函数和剪切函数构造了有限欧几里德空间域内帕斯威尔框架的离散剪切波,称为有限离散剪切波变换(Finite discrete shearlet transform,FDST),它不仅具有Curvelet和Contourlet变换的优点,同时具备平移不变性。

对于第二个问题,在已有的MSD融合策略中,低频子带多采用加权平均的方法,权重是直接与源图像的局部或全局显著特征(如均值、标准差)相关的值;高频子带利用区域窗口显著特征选取系数或加权系数的方法[ 10, 11, 12]。该方法融合过程易受噪声干扰,融合结果中容易引进虚假信息,得不到合适的亮度和对比度。文献[13]针对多层次曝光彩色图像提出了一种基于拉普拉斯分解的融合策略。该方法利用拉普拉斯金字塔对多层次曝光图像进行分解,利用图像曝光度、饱和度和对比度3种客观评价参数构造系数权重,得到较好的融合效果,但该方法中的各项客观评价参数仅适用于多层次曝光图像,对灰度图像不适用。受文献[13]的启发,本文提出了一种新的融合算法。采用有限离散剪切波变换作为源图像的多尺度分解工具,在低频子带区域窗口中,利用梯度信息相关性因子构造系数权重值,突出目标信息;在高频子带区域窗口中,应用系数绝对值与区域标准差一致性原则选取系数,消除可能出现的图像不连续性,使融合后的图像更符合人的视觉。

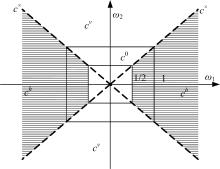

通过对函数 ψ∈ L2(ℝ2)进行膨胀、剪切和平移变换形成剪切波:

式中: Aa=

定义函数 ψ1, ψ2:ℝ→ℝ的傅立叶变换分别为:

令

函数 f∈ L2(ℝ)的剪切波变换定义为:

在

重叠区域为:

锥面 ch、 cv和交叉线 c×上的剪切波定义为:

低频部分 c0上的剪切波为:

剪切波的离散化主要是对式(1)和式(6)中的缩放比例参数 a、剪切参数 s和平移参数 t进行的。

式中: I: ={( m1, m2): mi=0,…, N-1, i=1,2}; J为分解尺度; ω∈{( ω1, ω2): ωi=- -1, i=1,2}。

在水平锥面与垂直锥面连接处 k=|2 j|,离散剪切波定义为:

图像 f的离散剪切波变换为:

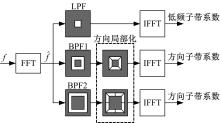

图像 f的有限离散剪切波变换过程主要分3步:频域转换、多尺度分解和方向局部化。频域转换是通过快速傅立叶变换得到图像 f的频谱。对频谱图像进行低通和不同频带的带通滤波得到低频子带系数和带通子带系数,使FDST具备了多尺度特性。方向局部化是通过剪切滤波器(SF)实现的,利用辅助函数构造频域剪切波,将带通子带系数与剪切波相乘,得到方向子带系数,使FDST具备了多方向特性,具体过程如 图2所示。FDST具有非常好的局部化特性,非常高的方向敏感性,满足抛物线尺度化特性。

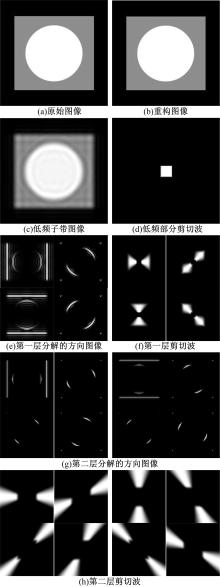

文献[9]证明上述离散剪切波构造了有限欧几里德几何空间域内的帕斯威尔紧支撑框架。有限离散剪切波变换过程中不存在下采样操作,使其具备了平移不变性。图像 f经过 J层FDST分解,会得到∑2 j+2个与原始图像尺寸大小相同的方向子带和1个低通子带,其中 j=0,1,…, J-1。 图3为图像testimage的2层分解图( J=2),第一层方向数为4,第二层方向数为8。

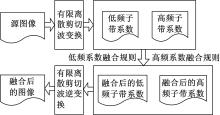

多尺度图像融合包括多尺度分解、子带融合和图像重构3个过程。待融合图像分别进行有限离散剪切波分解,得到低频和高频子带图像,对低频和各层高频子带图像分别采用不同融合策略进行融合,最后应用有限离散剪切波逆变换重构,得到融合图像,具体过程如 图4所示。

设源图像 I1和 I2经过FDST分解后得到不同尺度、不同方向的子带系数为:{ IL1, I

图像信号是高度结构化的,像素间具有很强的相关性,这些相关性携带了场景中物体结构和纹理的重要信息。人类视觉系统能够高度自适应地提取场景中的结构和纹理信息,因此对图像结构信息和纹理信息的改变量进行度量是感知图像质量的最好近似。文献[14]提出了一种将图像间结构信息和边缘纹理信息归一化到一个量对两幅图像间的相似度进行度量的方法,称为梯度信息相关性,非常符合人眼的视觉特性,具有很好的客观评价效果。设图像 x、 y,梯度图像为 x'、 y',区域窗口 w中心点( i, j)的结构信息和纹理信息相似度分别定义为:

式中: σx、 σy、 σx'、 σy'、 σxy、 σx'y'分别为图像 x、 y、 x'、 y'的窗口 w的标准差和协方差。 ci( i=1,2)是为了避免分母为零而引入的常数,且0 <ci≪1,当 ci的值远小于标准差和协方差时,对评价结果不会产生影响。

式(28)反映了局部亮度、对比度等结构的相似性。式(29)反映了梯度幅度的相似性,即边缘纹理信息的相似性,整合式(28)(29)信息,区域窗口 w的梯度信息相关性因子定义为:

低频子带融合的目的是在融合结果中根据源图像的局部特征尽量保持局部亮度、对比度和边缘纹理信息。在已有的加权平均融合方法中,权重都是直接与源图像的局部或全局显著特征相关的值,融合过程容易受到噪声的干扰,在融合结果中容易引进虚假信息,得不到合适的亮度和对比度。如果在融合图像已知的情况下,源图像与融合图像的梯度信息相关性因子的值越大,表明结构和纹理信息越相似,源图像中所对应的系数权值应越大;反之,应越小。本文受文献[13]启发,设计了一种利用初始融合图像与源图像间梯度信息相关性因子作为系数权重值的低频子带融合策略。具体步骤如下:

(1)低频子带均值加权融合

在低频子带中,采用等权值的加权平均,获取初始融合图像的估计,此种方法平均了源图像的亮度和对比度,但可作为评价因子计算的参考图像,以便获取最佳权重值:

(2)计算局域结构相似度参数

在系数矩阵 ILF、 IL1和 IL2中选择以点( i, j)为中心的局域窗口 N×N,再根据式(30)计算梯度信息相关性因子,得到 QG, IL1, F( i, j)和

(3)计算权重值

式中: α取非负值,用来调整权值的大小,当 α=0时, ωIL1 =ωIL2 =0 .5,此时为等均值权重,实际使用时一般取 α=1,表示源图像中权值偏离均值(0.5)的程度。

(4)计算低频子带融合系数

步骤(2)~(4)遍历整个低频子带系数矩阵,得到低频子带系数 IL。

高频子带图像反映图像的细节,如直线、轮廓等信息。高频子带融合的目的是提取源图像中的边缘结构。在已有的高频子带图像融合策略中,多采用直接选取绝对值最大系数(像素)或利用区域特征值(如区域平均能量)取大原则进行融合。直接选取绝对值最大系数(像素)可以获取图像中丰富的边缘信息,但这种方法只考虑了像素的单点信息,容易造成图像的不连续性。区域特征值取大融合策略由于考虑了区域内各像素之间的相关性,降低了对噪声的敏感性,但容易使图像轮廓与非轮廓区域之间模糊,造成融合图像清晰度下降。本文提出了一种系数绝对值与区域标准差一致性选择的高频子带融合策略,在降低对噪声敏感性的同时,最大限度地提取源图像中边缘细节信息,提高融合图像的清晰度。其基本思想是在区域窗口 M×M中,采用系数绝对值与区域标准差构造一致性选择因子,根据因子值选取区域中心点系数。具体步骤如下:

(1)在高频子带系数矩阵 I

式中: x的值为1或2; μx( i, j)为区域均值。

(2)计算一致性选择因子

当

(3)融合系数选择

上述过程遍历整个高频子带系数矩阵,得到高频子带融合系数 IHl, k。

本文通过4步试验来验证所提出的融合方法的有效性。第1步,在传统融合策略下,对DWT、Curvelet、Contourlet和FDST域的融合结果进行比较。第2步,在FDST域,对本文融合策略与典型的区域特征值加权及选择策略的融合结果进行比较。第3步,对不同多尺度分解域结合不同区域客观评价的融合结果进行比较。第4步,对具有多尺度、多方向性的FDST、NSCT、Contourlet的分解效率进行比较;对本文融合方法、文献[11]融合方法、文献[15]融合方法、文献[16]融合方法的融合效率进行了比较。通过视觉观察对融合图像进行主观评价。应用互信息MI[ 17]、信息熵EN[ 18]和边缘信息传递量QAB/F[ 19]三种指标对融合图像进行客观评价。

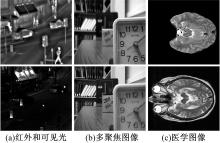

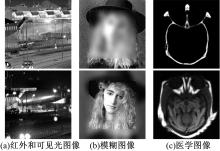

为了验证有限离散剪切波变换的多方向性和平移不变性在图像融合领域的优越性,在FDST域、DWT域、Curvelet和Contourlet变换域采用传统融合策略,即低频子带采用等权值平均、高频子带利用系数绝对值取大原则选取系数,对 图5(a)(b)和 图6(a)(b)所示的红外与可见光、多聚焦2组不同模态图像进行融合试验,并对融合结果进行客观评价。融合结果如 图5(c)(d)(e)(f)和 图6(c)(d)(e)(f)所示,客观评价数据如 表1所示。

| 图5 传统融合策略在不同多尺度分解域对红外和可见光图像的融合结果Fig.5 Infared and visible image fusion results using traditional fusion rule in different MSD domain |

| 图6 传统融合策略在不同多尺度分解域对多聚焦图像的融合结果Fig.6 Multi-focus image fusion results using traditional fusion rule in different MSD domain |

从 图5融合结果及放大图像中可以看到:在 图5(c)(d)(e)中目标周围出现不同程度的伪影或间隙,而 图5(f)则完全没有这种现象且融合图像清晰自然,对比度适中,有良好的视觉效果。这

是由于DWT、Curvelet、Contourlet变换缺乏平移不变性引起的伪Gibbs效应。 图5融合结果表明,在光谱差异较大的源图像融合过程中,FDST所具有的平移不变性能够有效地克服伪Gibbs效应。从 图6融合结果及放大图像中可以看到: 图6(d)(e)(f)中时钟边缘的刻画要优于 图6(c)( 图6(a)中下边缘有一定的弯曲),这表明Curvelet、Contourlet、FDST所具有的多方向性和各向异性对于图像边缘的刻画会更好。从 表1的数据可看到:应用FDST融合的图像客观评价指标均为最优,这也说明在图像融合领域,FDST要比DWT、Curvelet和Contourlet变换更具有优势。

| 表1 传统融合策略在不同多尺度分解域融合结果的比较 Table 1 Fusion results comparison using traditional fusion rule in different MSD domain |

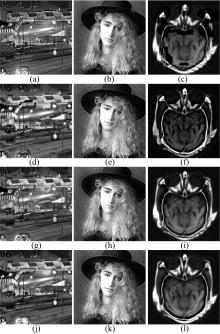

为了验证本文融合策略的有效性,在FDST域,分别应用本文融合策略(记为OA)、文献[10]融合策略(低频子带采用主成分分析(PCA)法、高频子带利用局域方差加权与选择结合的方法选取系数进行融合,记为PCAVAR)、文献[11]融合策略(低频子带采用区域空间频率构造权重、高频子带采用系数绝对值取大的原则选取系数进行融合,记为SFABS)和文献[12]融合策略(低频子带采用区域均值和方差构造系数权值、高频子带采用空间频率比的加权与选择结合的方法选取系数进行融合,记为VARSFR)对 图7中的源图像Ⅰ进行融合试验。融合结果如 图8所示, 图8(a)(b)(c)为文献[10]融合策略融合结果; 图8(d)(e)(f)为文献[11]融合策略融合结果; 图8(g)(h)(i)为文献[12]融合策略融合结果; 图8(j)(k)(l)为本文融合策略融合结果; 图8(m)(n)(o)为低频部分 ωIL1权值图像; 图8(p)(q)(r)为低频部分 ωIL2权值图像。客观评价数据如 表2所示。

从 图8中可以看出,在 图8(j)中行走的人、车、路和灯箱牌匾等都清晰可见,对比度适中,图像清晰自然,相对于 图8(a)(d)和(g)有更好的视觉效果,这表明应用本文融合策略能够更好地提取目标信息。在 图8(a)中,由于待融合图像相关性较弱,PCA方法在低频分量中没得到合适的权值,造成融合图像有一定的灰度失真。从 图8(b)(e)(h)(k)中可以看出,本文融合策略融合结果与文献[10-12]中融合策略的融合结果视觉上差异并不大,边缘刻画都较为准确,说明在光谱差异不大的图像融合过程中,4种融合策略都能得到较理想的结果。 图8(l)中,结构细节和纹理信息系统详实、图像清晰、亮度适中,相对于 图8(c)(f)(i)有更好的视觉效果,表明本文融合策略能够最大程度地提取源图像中的细节和保留源图像亮度信息。 图8(m)(n)(o)与 图8(p)(q)(r)中的权值图像也表明了本文低频融合策略中权值的有效性。对 图8进行分析可知,利用本文融合策略融合的图像更能体现源图像的细节信息,保证了图像的整体清晰度和保留了源图像中的结构和纹理信息。这是由于在低频子带图像中,应用梯度信息相关性因子作为系数权值,增强了融合图像的对比度,突出了目标信息;高频子带采用系数绝对值与区域标准差一致性选择策略,保留了边缘细节丰富区域,消除了可能出现的图像不连续性和去除椒盐噪声,使融合后的图像更符合人的视觉。从 表2可以看出:在FDST域,本文提出的融合策略融合的图像客观评价参数是最优的,表中数据与主观评价一致,进一步验证了本文融合策略的有效性。

| 表2 FDST域内不同融合策略融合结果的比较 Table 2 Fusion results comparison using different fusion rules in FDST domain |

为了验证本文融合方法的有效性,将本文融合方法(记为FDST_OA)与文献[20-22]中不同多尺度分解域结合不同区域客观评价的融合结果进行比较。文献[20]融合方法:在双树复小波(DTCW)域,低频子带采用区域相关系数构造权值进行加权融合;高频子带采用区域平均梯度取大策略选取系数,记为DTCWT_CG。文献[21]融合方法:在冗余提升不可分离小波(RLNSWT)域,低频子带采用区域梯度构造权值进行加权融合;高频子带采用区域梯度取大策略选取系数进

行融合,记为RLNSWT_LG。文献[22]融合方法:采用拉普拉斯分解(LP),低频子带利用区域窗口标准差构造权值进行加权融合;高频子带利用对比度和空间频率构造权值进行加权融合,记为LP_VAROA。源图像Ⅱ采用 图9中红外和可见光、模糊和医学3组不同模态图像。融合结果如 图10所示, 图10(a)(b)(c)为文献[18]DTCWT_CG融合结果; 图10(d)(e)(f)为文献[19]RLNSWT_LG融合结果; 图10(g)(h)(i)为文献[20]LP_VAROA融合结果; 图10(j)(k)(l)为本文融合方法FDST_OA融合结果。客观评价指标如 表3所示。

| 表3 不同多尺度分解域结合不同区域客观评价融合结果的比较 Table 3 Fusion results comparison based on different area objective assessment t in different MSD domain |

本文融合方法中,FDST得到的子带尺寸与原始图像尺寸相同,需要计算的区域窗口数量较多。在低频子带中,需要计算区域窗口标准差、协方差,相对于具有下采样过程的多尺度分解和直接采用区域窗口特征值的加权平均方法[ 11, 15]的融合效率要低,但本文方法能够进一步提高融合图像质量。

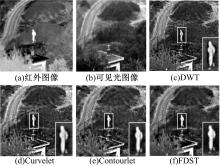

近年来,由于非下采样Contourlet波(NSCT)能够克服Contourlet变换不具备平移不变性的缺点而被广泛地作为多尺度分解工具,脉冲耦合神经网络(PCNN)能够有效地提取图像的细节特征,顾及图像的全局及单点像素特性而成为广泛应用的图像融合策略,取得了较好的融合效果[ 16]。但NSCT的分解和重构滤波器需满足Bezout等式,构造复杂、数据量大、计算效率低,同时PCNN融合规则需要计算神经元的链接强度和点火次数,增加了计算的复杂度。而本文的融合方法中,利用膨胀、旋转和剪切等仿射理论构造的FDST结构简单、易于实现、计算效率高,融合规则中只需计算窗口标准差、协方差等参数,相对降低了计算复杂度。因此,对于融合效率的比较分两步进行:①对FDST、NSCT和Contourlet分解效率进行比较,在比较过程中,融合策略均采用传统融合策略,分别记为NSCT_ABS、FDST_ABS和Contourlet_ABS。这样可以避免过多融合运算的时间消耗,突出多尺度变换本身的时间消耗;②将本文融合方法FDST_OA与文献[11]融合方法DWT_SFABS、文献[15]融合方法Contourlet_AVSF、文献[16]融合方法NSCT_PCNN的融合效率进行比较。试验过程中,FDST分解尺度为3,NSCT和Contourlet的尺度向量为[2,3,4],使分解的子带数保持一致,以体现公平性,DWT分解尺度为4。运行环境:Intel(R) Celeron(R) CPU2.4 GHz,2 G内存,MATLAB2008a平台,源图像采用 图11(a)(b)可见光和毫米波图像,灰度值为256,大小为256×256。试验结果如 图11所示,客观评价及运行时间如 表4所示。

由 表4可以看出:NSCT_ABS与FDST_ABS融合方法的评价指标接近,优于Contourlet_ABS。说明NSCT和FDST所具有的平移不变性能够提高融合图像的质量,但NSCT融合所消耗的时间是FDST的40倍之多,这说明虽然具有类似的平移不变性,但是NSCT方法是以高时间消耗为代价的。由 表4可以看出,本文融合方法FDST_OA的各项评价指标均优于DWT_SFABS、Contourlet_AVSF和NSCT_PCNN,但时间消耗要大于DWT_SFABS和Contourlet_AVSF,而小于NSCT_PCNN,这说明本文融合策略在得到较好融合效果的同时,具有较高的计算效率。

| 表4 不同多尺度分解融合方法计算效率比较 Table 4 Computation efficiency comparison of different MSD fusion methods |

针对已有的多尺度分解图像融合方法的缺陷,将FDST引入图像融合领域,提出了基于区域客观评价的FDST域图像自适应融合方法。利用膨胀、旋转和剪切等仿射理论构造的FDST具有结构简单、易于实现等优点,使其具有较高的计算效率。FDST所具有的抛物线尺度化特性、平移不变性、高的方向敏感性和优良的局部化特性,可有效地提取源图像的特征信息。在融合过程中,低频子带采用梯度信息相关性因子作为系数权值,高频子带应用绝对值与区域标准差一致性选择的融合策略。试验结果表明:本文提出的图像融合方法与其他融合方法相比较,能够得到较好的融合效果,具有较强的自适应能力。同时,本文所提出的融合策略也可应用于其他多尺度分解图像的融合。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|