作者简介:王世刚(1962-),男,教授,博士生导师.研究方向:多媒体通信,视频压缩,视频通信.E-mail:wangshigang@vip.sina.com

针对传统图像串扰度的测量需精密光学仪器,数据处理复杂且对环境光线要求苛刻的问题,提出了一种人眼观测结合亮度比例尺的双目图像串扰度检测方法。该方法首先生成用于串扰度检测的测试图,然后根据可视亮度相等原则选取最佳观测位置,最后通过对串扰区域与亮度比例尺间进行选择性匹配的方法得出串扰度的估计值。实验结果表明:本文方法的测试结果与HIS颜色模型的电脑测试结果完全相同,可以真实描述光栅式自由立体显示系统的串扰程度。同时,本方法的检测结果不受实验光线的影响,对检测环境具有很强的鲁棒性。

The measurement of traditional image crosstalk degrees needs precision optical instruments, which has a high requirement on the environment light and also causes a complex data processing. This paper proposes a new binocular image crosstalk degree detection method based on the human eye observation combined with the brightness scale. First, the test pattern is generated and used for crosstalk degrees detection. Then, the equivalent visual brightness principles are used to select the best observation position. Finally, the selective matching between the crosstalk area and the brightness scale are used to estimate the crosstalk degrees. The experiment results show that the test results of the proposed method is the same as the test results of HIS color model. It can accurately describe the degrees of crosstalk of the grating type auto-stereoscopic display system. At the same time, the test results of the proposed method is not affected by the light of the experiment, which proves that the proposed method is strong robust for the testing environment.

立体显示[1, 2]是一种能够同时提供符合立体视觉原理, 并且具有深度画面信息的技术, 现已在诸多领域内发挥着不可替代的作用。近年来不需要佩戴任何助视工具的裸眼立体显示技术备受研究人员青睐, 因其广阔的应用前景, 成为现今研发的一大热点。在立体显示技术中光栅式自由立体显示技术[3]有着制作成本相对低廉, 实验平台相对容易搭建, 并且适用于多用户场合、大尺寸显示等诸多优点, 但是也存在一些无法回避的问题。其中包括:莫尔条纹现象, 分辨率、亮度损失, 2D/3D兼容显示不易实现, 因人眼汇聚调节效应所引起的视觉疲劳以及双目图像串扰等现象。

产生双目图像串扰现象[4, 5]是因为双目图像并没有完全分离, 即左眼除了看到左摄像机拍摄的画面之外, 还会看到部分右摄像机拍摄的画面, 不仅会影响立体观看体验, 还有可能传递出错误的图像信息。串扰度的大小会随着观看者位置的改变而改变, 通常在立体视区内串扰度较小, 在立体视区外串扰度比较严重。只有在光栅参数、显示器参数、视差图像拍摄参数以及多视点图像生成方法等各个因素都能良好匹配时, 才会让串扰现象降到最低。因此, 串扰现象的严重与否是衡量一种自由立体显示技术优劣的关键所在。

本文针对双目图像串扰度这一指标提出了一种双目图像串扰度检测方法, 该检测方法不但简化了传统图像串扰度的计算过程, 而且操作简单、易于实现, 并经过相应的验证试验证明了其有效性与实用性。

以两视点自由立体显示系统为例, 串扰度的一般计算方法[6, 7, 8, 9, 10]为:在一个无光的环境中, 观测者保持待测位置不动, 系统显示器关闭右视图相应像素点, 仅显示左视图信息, 观测者利用光量传感器记录此时的光强BL; 系统显示器关闭左视图相应像素点, 仅显示右视图信息, 观测者利用光量传感器记录此时的光强BR; 系统显示器关闭所有像素点, 观测者利用光量传感器记录此时的光强BO。则右视图对左眼在该位置的串扰度CL、左视图对右眼在该位置的串扰度CR分别为:

如果实验在理想的暗室环境中进行, 且显示器工作在理想状态下, 则显示器亮度为0, 即BO=0。假设屏幕各像素点亮度性能参数相同, 右视图发光部分平均亮度为IR, 发光面积为SR; 左视图发光部分平均亮度为IL, 发光面积为SL, 则式(1)和式(2)可表示为:

若保证视差图发光部分的面积相等, 则式(3)和式(4)又可表示为:

式中:CK为观测点K处的双目图像串扰度; IO为K处串扰图像的平均亮度; IK为K处应该观测到的主视点图像平均亮度。

从以上描述中可以看出, 传统的测试方法要求测试环境的光线强度接近于0, 且需使用昂贵精密的光学仪器, 在通常情况下, 上述苛刻的测试条件显示无法实现, 为此, 本文提出了一种人眼识别结合亮度比例尺的图像串扰度检测方法。

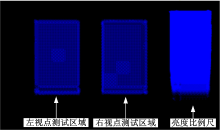

如图1所示, 本文以两视点自由立体显示系统为例, 利用绘图软件生成用于图像串扰度检测的测试图, 其中, 左侧的蓝色区域为左视点测试区域, 该区域的奇数列像素点为黑色, 偶数列像素点为100%亮度的蓝色; 中间的蓝色区域为右视点测试区域, 该区域的偶数列像素点为黑色, 奇数列像素点为100%亮度的蓝色; 右侧的蓝色区域为亮度比例尺, 该亮度比例尺由10条亮度依次递减10%的蓝色矩形组成, 其中, 最上方的矩形区域亮度为100%, 最下方矩形区域亮度为0(黑色)。

本文以左视点为例介绍图像串扰度的检测方法(右视点与左视点的测量方法相同), 在测试过程中要求测试人员使用单眼进行观测。

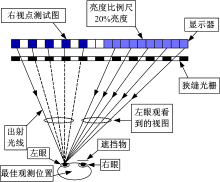

对于最佳观看位置的情况, 首先确定左视点图像的最佳观测位置, 最佳观测位置需保证左视点所对应的显示屏上的每个像素点的出射光线均可通过其前方的狭缝进入人眼。在本文所提方法中, 从最佳观测位置观看到的左视点测试区域的图像亮度应与观看到的亮度比例尺中100%亮度区域的图像亮度相同, 如图2所示, 左视点测试区域共有5个像素点, 且均可透过狭缝光栅, 每个像素点都会产生100%的单位光强。显示器右侧的亮度比例尺中可以透过狭缝光栅的部分也为5个亮度为100%的像素点。

在实际操作中, 观测者只需找到左视点测试区域的观看亮度与亮度比例尺中100%亮度区域的观看亮度相同的位置, 该位置即为左视点图像的最佳观测位置, 串扰度最低。

接下来需要测试人员对CK的值进行估算, 如图3所示, 在最佳观测位置处, 设右视点测试区域共有5个像素点, 每个像素点都会产生100%的单位光强, 但其中4个像素点发出的光线被狭缝光栅的不透光部分所遮挡。显示器右侧的亮度比例尺可以透过狭缝光栅的部分为5个像素点, 当亮度比例尺的亮度为20%时, 观测者从右视点测试区域中看到的亮度与从亮度比例尺中看到的亮度相同。由式(5)可得:

由式(6)可知:在本方法中, 双目图像串扰度CK即为与右视点测试区域具有相同观看亮度的亮度比例尺所对应的百分比。

在实际操作中, 只需找出该待测矩形区域在亮度比例尺中所对应亮度相同或最为接近的亮度级别, 并估算其值, 所得即为双目图像串扰度CK的近似值。

对于在非最佳观测位置进行观测的情况, 首先, 按照上述方法, 确定此时左视点测试区域在亮度比例尺中的对应亮度级别, 记为m, 然后, 保持观测位置不变, 再确定右视点测试区域在亮度比例尺中的对应亮度级别, 记为n, 则非最佳观测位置的串扰度C'K为:

为了验证所提方法的有效性, 本文在22寸的LCD显示器上搭建了基于狭缝光栅的自由立体显示平台, 具体参数如下:点距为0.282 mm, 光栅节距为0.564 mm, 狭缝宽度为0.282 mm, 暗条纹宽度为0.282 mm, 视点为2。

21名测试者参加了本次实验, 他们的矫正后视力均可达到4.8以上, 且无色盲和散光。其中男性测试者11名, 女性测试者10名; 从事图像方面研究的测试者5名, 从事非图像方面研究的测试者16名; 测试者中包括4名中年人, 其余均为青年。

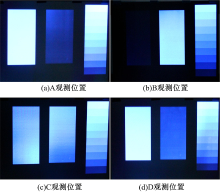

测试者分别在A、B、C、D四个位置对显示效果(如图4所示)的串扰度进行了评价, 其中, 图4(a)(b)的观测位置分别为左视图和右视图的最佳观测位置, 图4(c)(d)的观测位置为非最佳观测位置, 测试结果如表1所示。

| 表1 串扰度测试结果 Table 1 Test results of crosstalk degree |

根据Contrast Ratio和Cross-talk Levels的经验值, 窜扰度小于等于10%时就能够说明该自由立体显示系统的性能良好。由表1可知:21名测试者在A、B、C、D四个观测位置的测试结果完全一致, 测试者都能够轻易地找出测试图中待测矩形区域所对应的亮度比例尺刻度, 毫无分歧。

接下来验证本文测试方法所得测试值的准确性。通过CCD相机在暗室中获取测试位置的CCD图像, 利用HIS颜色模型, 分别求出各测试位置的IO、IK和CK值, 如表2所示。从表2中可以看出, 由本文所提方法得出的图像串扰度与HIS颜色模型的计算结果完全吻合。

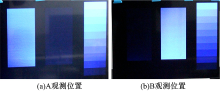

图4的显示条件为环境光强接近于0的暗室, 为了讨论环境光强对实验结果的影响, 本文在夜间室内正常照明且仅关闭直射显示器的光源的环境下, 对图4(a)(b)中的两个观测位置进行串扰度检测, 非暗室环境下的显示效果如图5所示, 21名测试人员再次进行测试后, 测试的结果并未发生变化。

| 表2 准确性测试结果 Table 2 Test results of veracity |

实际上, 从图中也可以很容易看出, 环境光线的加入并未改变待测矩形亮块所对应的比例尺刻度块, 传递给观测者的信息也未发生变化, 所以对测试结果不会产生影响。

本文提出的双目图像分离度检测方法在多视点自由立体显示系统中仍然适用。该方法对环境的依赖程度较低、无需光量传感器等昂贵、精密的光学实验仪器参与就能够准确、直观地测试出自由立体显示系统的双目图像分离能力。测试方法对测试人员的数量和素质等因素无依赖, 仅需要一双视力较好、无色盲、无散光的健康眼睛就可以得到理想、准确的测试结果。同时, 本文所提方法能够简单、有效地找出自由立体显示系统的最佳观测点, 能够为自由立体显示系统显示效果评价提供参考指标。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|