作者简介:宋超(1986-),男,博士研究生.研究方向:LED显示控制及图像处理技术.E-mail:troysung@163.com

针对色域映射失真类型图像,在传统算法的基础上提出了一种新的图像质量评价方法。首先,阐述了该评价方法对图像特征提取的目的及方法,并形成最终的评价公式GMSIM。然后,使用已有的3个色域映射图像集和TID2008图像库对GMSIM算法进行参数拟合和预测准确性分析,对色域映射图像库采用命中率来表征算法性能。实验结果显示:GMSIM算法对色域映射失真图像主观感知的预测准确性比传统的SSIM方法提高约4.5%,但仍有较大的进步空间;在TID2008图像库的预测性能也有所提高。

For gamut mapping distortion type images, a new image assessment method was proposed based on traditional algorithms. First, each image feature extraction objective and extraction method were elaborated, and a final assessment formula, named GMSIM, was established based on these features. Then, applying three existing gamut mapping image sets and the TID2008 image library, the parameters of the GMSIM algorithm were fitted, and the prediction accuracy of the algorithm was analyzed. For gamut mapping image sets, hit rate was used as indication of the algorithm performance. Experiment results show that, compared with traditional SSIM method, the proposed GMSIM algorithm prediction accuracy of subjective perceptions for gamut mapping distortion images was improved by about 4.5%, although there is still much room for improvement. The prediction performance for TID2008 image library is also improved to some extent.

目前已有的客观图像质量评价算法在预测常见图像失真类型(如有损压缩、噪声和模糊等)的主观感知方面表现出很好的准确性[1]。黄小乔等[2]在S-CIELAB色差模型的基础上, 提出一种基于色差的均方误差与峰值信噪比彩色图像质量评价方法, 首先将图像分别经过S-CIELAB空间滤波处理后, 再转换到CIELAB均匀颜色空间, 然后利用CIELAB色差公式计算两幅图像每一个像素间的色差, 最后计算色差均方根和色差峰值信噪比以进行质量评价。实验结果表明, 该算法的客观评价结果与平均主观评价分数具有较好的一致性。王宇庆等[3]针对传统的图像质量评价方法忽略颜色信息的问题, 提出一种使用四元数矩阵来描述彩色图像结构信息的客观评价方法。该方法对四元数矩阵进行奇异值分解, 将最大奇异值作为度量图像结构相似性的主要参数, 并通过分析图像结构差异映射图谱得到评价结果量化值。使用LIVE图像库测试的结果表明, 该方法与人眼视觉感知特性的一致性优于传统方法。武海丽等[4]比较了S-CIELAB和iCAM两种模型对图像质量评价结果的有效性和准确性, 分别使用两种模型计算两幅图像的色差并与主观实验结果进行对比, 发现iCAM模型色差计算结果比S-CIELAB模型更符合人眼视觉实验结果。Baranczuk等[5]利用客观图像质量评价指标对色域映射后的图像质量进行评价, 以心理物理学主观评价结果为参照选择出最优的评价指标, 结果证明SSIM具有比主观评价结果更好的预测准确性。但上述方法均利用了图像的颜色信息, 但都没有考虑色域映射失真图像的特点, 在实验验证时也未利用色域映射图像进行验证, 对映射图像主观评价结果的预测准确性均有待验证。

本文针对色域映射失真类型图像, 在FSIM[6]算法的基础上, 提出了一种能够提高色域映射图像预测准确性的图像质量评价方法, 可用于开发新的色域映射算法, 也可在一定程度上代替复杂费时的主观评价实验对色域映射算法的效果进行验证。

首先将源图像和映射图像都转换到CIELAB均匀颜色空间中。对图像的明度分量, 根据人类视觉对相位一致的不同频率的波具有较高的分辨率的特性, 首先提取图像明度分量中的相位一致性信息作为图像的一个特征。由于相位一致性特征具有对比度不变性, 而视觉具有对比度敏感性, 因此提取图像明度分量中的边缘强度作为另一个特征。对图像彩度和色相分量, 根据色域映射的特点, 分别提取彩度和色相分量的彩度差和色相差作为图像的另外两个特征。

相位一致性(Phase congruency, PC)是一种特征点检测方法, 与传统的基于图像亮度梯度的方法不同, 它利用图像信号在特征点处的傅里叶分量具有最大相位一致性的特性来进行特征点的检测。目前已有多种提取给定图像PC图的实现方式, 本文使用Kovesi[7]提出的一种改进的PC提取方法, 该方法已广泛应用在各种图像处理中。

为了计算二维明度图像的PC特征, 采取从一维信号到二维信号扩展的思路。首先对于一维信号g(i), 分别用

令F

式中:E

对上述一维信号, 本文采用Log-Gabor滤波器组作为滤波器正交对。一维Log-Gabor滤波器在频域中的转换函数为:

式中:ω 0为滤波器的中心频率; σ r为控制滤波器的带宽。

对上述一维Log-Gabor滤波器的垂直方向利用高斯函数作为扩展函数, 将一维Log-Gabor滤波器扩展到二维, 计算二维明度图像的PC特征。使用高斯函数作为映射函数, 得到二维Log-Gabor函数的转换函数如下:

式中:j={0, 1, …, J-1}; θ j=jπ /J为滤波器的方向角, J为方向数; σ θ 决定方向角的角带宽, 例如在频域中的二维Log-Gabor滤波器, ω 0=1/6, θ j=0, σ θ =0.4, 如图1所示, 其中图1(a)为滤波器的径向分量, 图1(b)为滤波器的角度分量, 图1(c)为径向分量和角度分量相结合的Log-Gabor滤波器。

通过调整ω 0和θ j的值, 并使用二维Log-Gabor滤波器G2D(ω , θ j)对二维明度图像作卷积, 对每个像素位置i得到对应的向量

在尺度为n、方向为θ j时, 局部幅度表示为:

沿方向θ j的局部能表示为:

式中:

最终可以得到二维明度图像在像素位置i处的相位一致性为:

式中:PC2D(i)为0到1之间的实数。

边缘是指图像中指示语义目标边界的像素集, 一般是通过寻找图像中亮度急剧变化的像素集来确定的。图像边缘包含以下两个特点:沿特定方向的局部连续性和沿正交方向的局部不连续性, 如图2(a)所示, 其中红色箭头指示沿特定方向的规则信息, 黄色箭头指示正交方向的不规则信息。本文认为, 图像中存在各向异性结构并且边缘总是向各个方向延伸[8]。将上述3个特点全部包含在内, 构建了新的边缘强度特征提取方法。

将源图像表示为O=

用∂Oi

为了符合人眼视觉, 引入ρ 作为边缘强度非线性调节因子。类似地, 在对角线的边缘强度定义为:

因为人眼视觉系统对显示更强边缘强度的方向更敏感, 定义第i个像素的整个边缘强度为:

这个新定义的边缘强度把边缘的3个特征考虑在内, 并且能够使用卷积快速计算。

将源图像O的色域映射图像表示为R=

每个像素的方向导数∂ Oi(d)是通过使用卷积核K

卷积核的设计或选择在图像质量评价研究中十分重要, 不同的卷积核会导致不同的评价性能。在FSIM[6]算法中, 作者对3种图像梯度卷积核(Prewitt, Sobel, Scharr)进行了比较, 结果显示Scharr算子能够达到最好的效果。本文中上述卷积核K(j)即在Scharr算子的基础上设计的。

在大部分情况下, 色域映射过程中颜色失真是必然的。颜色三属性中, 色相是感知和辨别颜色中最主要的颜色属性。大部分色域映射算法都是以保持色相不变为原则, 并且基本上都是在CIELAB均匀颜色空间中保持色相角不变来实现, 然后在明度和彩度分量上进行颜色映射[9]。但是, 色相角并不能完全反应视觉感知的色相, 也就是说, 即使颜色在相同色相角平面上移动, 人眼仍然会感知色相的改变, 这是由于色空间本身的不均匀性引起的。

为了表征色域映射图像与源图像的颜色分量的相似性, 分别提取源图像和映射图像在像素位置i的彩度差和色相差:

式中:C(O, i)、C(R, i)分别为源图像和映射图像在像素位置i的彩度分量; a(O, i)、a(R, i)、b(O, i)、b(R, i)分别为对源图像和映射图像在CIELAB均匀颜色空间中分解对应的a和b分量。

本文中Δ H是用欧几里得距离而不是用色相角的差值来表示的, 一方面是因为在CIELAB均匀颜色空间中, 即使两种颜色的色相角的差维持不变, 随着彩度的增大, 视觉色相差也会增大。另一方面, 使用色相角的差来衡量色相变化, 不易对色相的相似性比较进行公式化。

利用从图像明度分量中提取的相位一致性特征、边缘强度特征和从彩度与色相分量中提取的彩度差特征、色相差特征, 设计了一种可用于色域映射失真类型的图像质量评价方法。为方便起见, 本文将这种算法称为色域映射相似性评价算法(Gamut mapping similarity, GMSIM)。

对于图像明度分量, 从源图像O中提取的相位一致性和边缘强度特征分别为PC(O, i)和ES(O, i), 从映射图像R中提取的相位一致性和边缘强度特征分别为PC(R, i)和ES(R, i), 则源图像O和映射图像R明度分量相似性由两部分构成, 其中相位一致性特征相似性定义如下:

边缘强度特征的相似性定义如下:

式中:Q1和Q2均为正实数, 用于提高SPC和SES的稳定性, 其值大小分别取决于PC和ES的动态取值范围。

式中:B为预先设置的常数; ρ 为边缘强度非线性调节因子。

图像中不同的像素位置在人眼视觉系统对图像视觉感知的贡献是不同的, 例如边缘位置就比平滑区域传达了更重要的视觉信息。因为人眼对相位一致性结构具有敏感性, 取源图像O和映射图像R相位一致性的最大值作为权重, 用于图像明度分量的相似性度量。图像明度分量的相似性权重定义如下:

PCm

图像明度分量的相似性可定义如下:

式中:α 和β 是用来表示相位一致性和边缘强度特征重要性的参数。

根据源图像O和映射图像R彩度差和色相差的定义, 取在图像彩度分量和色相分量的相似性定义为:

式中:参数Q3和Q4用于调整所检测的彩度差和色相差大小。

将所有相似性结合在一起, 即可得到源图像O和映射图像R的相似值如下:

GMSIM=∑ iSL·

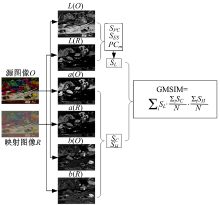

GMSIM算法在实际应用中的流程见图3。

本文中选用TID2008图像库[10]作为GMSIM算法参数调试和算法性能验证的一部分图像源。TID2008数据库共有1700幅测试图像, 包括25幅源图像, 对每幅源图像各有17种失真类型, 每种失真类型有4个失真等级。数据库的主观测试值(Mean opinion scores, MOS)是由3个国家共约256 000人次实验的基础上获得的。

使用已有色域映射算法主观对比实验中形成的3个图像集[5]作为GMSIM算法参数调试和性能验证的另一部分图像源。这几个图像集包含约15种色域映射算法及其组合, 共有234幅源图像, 2136幅色域映射图像, 共有14 106次有效主观对比评价。在图像集形成的主观对比评价实验中, 将两幅色域映射图像并排, 并将源图像置于两幅映射图像的下方, 3幅图像同时展示给观察者。观察者从两幅映射图像中选择与源图像更相似的一幅, 完成一次对比评价。

在TID2008图像库中, 最终主观评价结果是以MOS值的形式给出。客观图像质量评价算法对整个图像库进行处理, 并将运算结果与MOS值作相关性分析。相关度越高, 则客观图像质量评价算法对主观评价结果的预测性越好。

对色域映射失真类型图像而言, 将观察者对比选择原始数据转换到MOS需要假设并选择原始数据分布模型、分析观察者内和观察者间的不确定性以及分析图像内容对选择结果的影响等各种因素。因此, 本文使用命中率来衡量图像质量评价算法对色域映射图像主观对比评价结果的预测准确性。命中率p的计算式为:

式中:m为主观对比评价总次数; h为客观评价算法成功预测主观对比评价的次数。如果某图像质量评价算法命中率p≈ 0.5, 则表示该算法预测性能很差, 其效果近似为随机预测。

在对色域映射图像集的主观评价实验中, 不同的观察者对同样的两幅色域映射图像做出的主观评价可能是不同的。因此, 客观评价算法对主观对比评价的命中率不可能为1, 而是有一个最大值pm。只有对同样的两幅色域映射图像做出的主观对比评价中的大多数选择做出成功预测, 客观图像质量评价算法的命中率才能达到pm。因此, 算法的命中率存在一个取值区间即

从3个色域映射图像集中随机抽取一半源图像作为训练图像集, 用于本文图像质量评价算法的参数拟合。该训练图像集中共包括117幅源图像, 1068幅色域映射图像, 共对应7932次对比评价结果。使用该图像集对客观图像质量评价算法中的各个参数进行试错性选择, 使得算法的命中率达到最大。最终得到的参数如下:N=4, J=4, σ r=0.5978, σ θ =0.6545, Q1=1.2, α =1, ρ =0.9, B=0.126, Q2=62.75, β =0.8, Q3=0.000 25, Q4=0.002。Q1、Q2和Q3、Q4在各自的相似性公式中使用的方式不同, 因此不能相互比较。

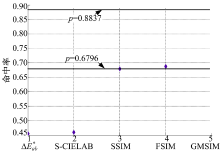

3个色域映射图像集的全部图像及主观对比评价结果用于测试GMSIM算法的预测准确性, 同时使用CIE推荐的色差公式Δ

对Δ

式中:N为源图像中的像素个数。

SSIM和FSIM图像质量评价算法仅使用图像的明度分量进行运算。各种图像质量评价算法得到的命中率如表1所示。

| 表1 图像质量评价算法命中率对比 Table 1 Comparison of hit rates |

从表1可以看出: Δ

对SSIM、FSIM和GMSIM这3种图像质量评价算法在TID2008图像库进行了性能评估和比较, 并使用肯德尔等级相关系数(Kendall rank-order correlation coefficient, KROCC)和斯皮尔曼等级相关系数(Spearman rank-order correlation coefficient, SROCC)两种评价指标进行评价对比。等级相关系数能够测量图像质量评价方法的预测单调性, 一个更好的客观图像质量评价方法应该有更高的KROCC值和SROCC值。因为TID2008图像库为RGB数据, 首先将其从RGB颜色空间通过sRGB转换公式转换到CIELAB均匀颜色空间, 提取图像的明度图像, 然后使用3种图像质量评价算法进行处理。对GMSIM图像质量评价算法, 不使用其彩度和色相分量的相似性公式。

3种算法在TID2008图像库的预测性能对比如表2所示。从表2中可以看出:GMSIM算法优于SSIM算法和FSIM算法。因为梯度信息在只考虑图像中每个像素的平均变化, 并没有将边缘的3个特征同时考虑在内, 算法的比较结果也证明了边缘的3个特征的有用性。

| 表2 TID2008图像库中图像质量评价方法性能比较 Table 2 Performance comparison of IQA methods on TID2008 image database |

将3种算法得到的客观评价结果与TID2008图像库提供的主观评价结果绘制成散点图, 根据散点数据可得到主观观测值和各种算法的客观预测值的拟合曲线, 如图5所示。从图中可以看出:本文提出的GMSIM算法得到的散点图比SSIM和FSIM具有相对更好的聚合度, 拟合曲线线性度更好。

本文针对色域映射失真类型图像提出了一种新的图像质量评价方法GMSIM。使用3个色域映射图像集和TID2008图像库对GMSIM算法进行参数拟合和算法预测准确性分析。实验结果显示:GMSIM算法对色域映射失真图像主观感知的预测准确性比传统的SSIM方法提高约4.5%, 但仍有较大的进步空间。在TID2008图像库的预测性能也有所提高。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|