作者简介:张文杰(1987-),男,博士研究生.研究方向:图像处理与智能计算.E-mail:daaiyiyejian@cqu.edu.cn

依据图像区域的对比度以及空间位置等先验视觉显著性知识,进行了自下而上、数据驱动的图像显著性区域检测。首先,提取图像中的前景区域,构造区域的对比度、空间位置特征函数,然后融合这些特征计算显著图。该算法将图像的空间关系与区域关系联系起来,得到了较精确的显著图。通过对国际上现有的公开数据集MSRA-1000的测试结果表明:本文算法可以抑制非显著区域干扰,显著图的一致性较高。同时,将本文算法的显著图应用于分割显著性区域,能够得到较好的分割效果。

A bottom-up data driven algorithm is proposed to extract image salient region by utilizing visual saliency prior knowledge such as regional contrast and spatial location etc. In this algorithm, first, the foreground region in the image is extracted. Then, the regional contrast and spatial position feature functions are constructed. Finally, the saliency map is acquired by fusing these features. The model well establishes the relationship between the spatial space and regional contrast, and generates saliency maps with precise details. The results demonstrate that the proposed method consistently outperforms existing saliency detection algorithms, suppresses non-significant regional disturbance, and yields higher consistent saliency map, when evaluated using one of the large publicly available data sets MSRA-1000. Meanwhile, the extracted saliency map is applied to automatically segment saliency region and better segmentation results are obtained.

视觉显著性是神经学、心理学、神经系统和计算机视觉的一个基本问题[1]。视觉显著性是视觉感知能力的体现, 它使被感知对象(或区域)更加突出地显示出来。同时Gestalt原理指出:人类视觉一般只关注场景中的一个或几个中心区域, 而对于中心区域以外的背景区域关注程度较低。图像显著性检测的主要任务是估计图像中的这些中心区域, 保证中心区域的显著性高于背景区域的显著性, 其相关检测技术在基于内容的图像检索[2, 3]、目标识别[4]、图像分割[5]等领域都具有广泛的研究及应用价值。

图像显著性检测方法可以归结为基于任务驱动、自上向下的算法[6, 7]和基于数据驱动、自下而上的方法[8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19]两类。自上向下的方法重点研究特定某一类的显著对象, 其图像的显著特征需要一个较大规模且包含特定对象的数据集通过相关监督式学习算法训练得到。而自下而上的显著性检测方法则主要依据底层的数据信息, 不依据特定检测任务自发提供视觉显著性信息。本文关注的重点是自下而上图像显著性区域检测。近年来, 自下而上的显著性研究得到了国内外学者的关注。Itti等[8]提出了基于视觉注意机制的显著性检测算法。Ma等[9]基于对比度的模糊生长的方法进行图像显著性分析。Harel等[10]提出基于图的显著性检测算法, 该算法在特征提取过程中使用了Itti算法的特征, 并且引入马尔可夫链计算显著图。而Hou等[11]利用光谱余量检测显著性。这些算法研究的重点是图像中的显著点, 因此显著图中显著对象比较模糊。后来, 许多学者关注图像中的显著对象或区域。Achanta等[12]使用高斯差分方法提取全分辨率的显著图, 这种方法简单高效, 但是不利于复杂背景下的显著性对象检测。Stas等[13]提出了上下文感知的显著性检测算法, 检测的显著性对象边缘特征比较明显, 并且一致性不高。文献[14]在Stas算法[13]的基础上提出一种随机的视觉显著性检测算法, 该算法具有较快的运算速度。郭迎春等[15]提出一种基于颜色对比的显著性区域检测算法。文献[16-17]提出一种联合显著性(Co-Saliency)检测方法, 检测一个图像集中的共同显著性对象。Xie等[18]用贝叶斯框架提取图像显著区域, 该算法重点关注检测效果, 并且得到了较好的检测结果, 算法的不足之处是显著点不在显著性对象周围或分散在较大区域时检测效果欠佳。Cheng等[19]提出一种基于区域对比度的方法结合区域颜色距离度量与空间距离度量检测图像的显著性, 算法效果较好, 算法的局限性在于显著性检测过程仅利用了对比度特征, 对背景复杂图像检测结果有待提高。

总体来说, 目前图像显著性区域检测研究取得了许多新成果, 但是仍然值得进一步研究, 如:显著区域不能被一致突出; 显著图中显著值较高的区域不在目标区域, 而是集中在变化剧烈的边缘部分或复杂的背景区域等。本文从Cheng算法(RC11)[19]得到启发, 依据显著性检测的先验知识, 提出一种自下而上、数据驱动的图像显著性区域检测算法。同时本文提出一种新的初始化GrabCut算法的方法, 将本文得到的显著图应用于图像显著分割, 提取图像中的显著对象。

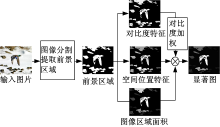

本节分析了影响图像显著性的两个重要特征:对比度和空间位置, 并利用这些先验显著性特征构造显著性的对比度和位置特征函数。首先利用基于爬山算法的图像分割方法[20, 21]将图像分割成不同的区域, 并提取图像的前景区域, 然后构造区域的对比度特征、空间位置特征函数, 同时考虑区域面积因素, 计算显著图。本文算法流程如图1所示。

在视觉注意过程中, 往往是那些独特性、不可预测性、稀缺性以及奇异性的对象被引起注意, 其他对象以及背景被关注程度较低。本文算法首先考虑去除图像背景区域干扰, 然后在前景区域中检测图像的显著区域(对象)。基于现有视觉显著性的研究[22, 23, 24, 25], 显著性区域出现在图像边界上的可能性较小。在本文中, 利用这一性质, 考虑将与图像4个边界接触面积最大的区域设定为背景区域, 在图像的前景区域中利用区域对比度、位置特征计算显著对象, 减少背景对检测结果的影响。

对于一幅图像, 人们会更加关注与周围物体的对比度差异非常大的区域[19, 26]。此外, 区域空间关系在人类视觉注意方面也起很大作用; 相邻区域的高对比度比相距较远区域的高对比度更容易导致一个区域引起视觉的注意[19]。对比度较好地反映了视觉显著性对新异对象的刺激。本文从文献[19]基于区域对比度方法得到启发, 但与文献[19]的方法不同, 本文计算图像对比度时忽略背景区域的对比度干扰, 构造图像区域对比度特征函数衡量区域空间距离、颜色距离在检测显著性区域时的贡献。具体而言, 在计算两个区域的对比度时, 本文使用区域空间距离作为区域对比度权重, 结合区域颜色距离特征构造图像区域对比度特征函数Ck, 使相距较远的区域对图像对比度贡献较小, 相距较近的区域贡献大, 其公式如下:

式中:rk、rm分别为图像中的第k个区域和第m个区域; Ck为第k个区域rk的对比度特征函数; Dr(rk, rm)为rk与rm的对比度; dr(rk, rm)为rk与rm之间的欧氏距离, 本文使用区域的质心计算区域之间的距离; rk(i)、rm(j)分别为区域rk、rm在RGB颜色空间的颜色向量; nk、nm分别为rk、rm中所包含的颜色总数; n为图像区域的总数; pk(i)为在图像区域rk中rk(i)出现的概率; pm(j)为在图像区域rm中rm(j)出现的概率。

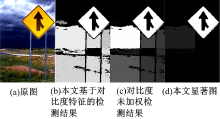

| 图2 基于区域对比度与空间位置特征的显著图Fig.2 Saliency map based on the trait of regional contrast and spatial position |

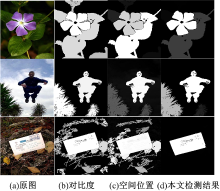

基于区域对比度特征的显著性检测结果如图2(b)列所示。基于区域对比度的显著性检测优点是对于对比度特征突出的图像能较好地提取显著性对象, 如图2(b)第一幅图像花的对比度较突出, 可以利用对比度特征提取显著对象; 但是基于对比度的方法在前景区域提取显著性对象时也会存在一些不足, 例如图2(b)第二幅图像中前景区域间的对比度特征差别并不明显, 很难分辨人与树哪个对象显著性更高。因此, 融合多个图像特征提高算法显著性检测能力成为一种行之有效的方法。

回顾人类视觉注意机制, 人类往往转动视角将感兴趣的对象集中在视角中心[27]。同样, 在图像采集过程中, 人们通常将引起注意的对象聚焦在图像中心。本文将图像区域位置信息引入到显著性检测过程。具体而言, 利用区域与图像中心的距离关系构造空间位置特征函数, 使距图像中心近的区域显著性高, 距中心较远的区域显著性低。归一化的图像区域的位置特征函数定义如下:

式中:Pi为第i个区域ri的位置特征函数, Pi∈ [0, 1]; (xi, yi)为第i个区域的质心坐标; h、w分别为整幅图像的高度和宽度。

依据位置特征得到的图像显著图如图2(c)列所示。由图2(c)可见, 本文构造的位置特征函数在检测图像显著性时发挥了较好的作用。但是, 图像中区域的显著性与区域对比度、位置等因素有关, 仅将该特征用于显著性检测存在不足, 图2(c)第一幅图使用花的位置特征检测显著区域就是一个失败的例子。

视觉焦点的深度搜索原理[28]是视点首先被一个较大的区域吸引。对象区域的大小也会影响底层的视觉刺激, 因此, 本文也将图像区域面积作为影响图像显著性的因素, 定义显著性的权重参数Wi:

式中:Ri为第i个区域的面积。

本文在进行显著性检测时, 考虑了区域对比度、空间位置、图像区域面积等因素, 但在不同的图像场景中往往是这些因素中的一个或几个因素起到主导作用, 例如在图2(a)列中, 第一副图像中花的对比度占主导作用; 而第二幅图像人所在区域空间位置起到关键作用。如何结合各种因素是建立适当的显著性检测模型的关键。本文融合上述特征构建显著性检测模型, 首先将上述区域对比度特征、空间位置特征以及面积因素相乘检测图像的显著性, 即:

该方法实验结果较好, 但是对比度特征没有较好发挥作用, 图2(c)为一例检测失败的例子。对此, 本文对该显著性检测模型改进, 提出对比度加权的图像区域显著性检测算法, 其公式如下:

式中:λ 为图像区域对比度增强系数, 实验结果表明, λ =1.6时能够得到较好的实验结果。

对比度加权检测结果如图3(d)列所示, 能够较好地反映区域对比度、空间位置、区域面积在显著性检测时的作用。同时, 该方法也可以较好地排除背景及非显著区域干扰, 获得较为干净的背景, 从而突出显著性对象。

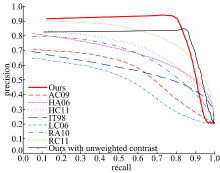

实验给出了基于本文区域对比度特征, 本文算法对比度未加权以及对比度加权的检测结果比较, 同时还比较了其他7种被引用较多的算法(IT98[8], HA06[10], AC09[12], RC11[19](基于区域对比度), HC11[19](基于直方图), RA10[29], LC06[30])与本文算法的实验结果。

本文采用Achanta等[12]提供的公开测试集MSRA-1000验证算法的性能。该数据集包含1000幅图片, 并且提供人工标注的精确显著图(Ground truth, GT)。

本文通过PR(Precision-recall)曲线评估算法的性能。PR曲线由准确率Pr和召回率Re构成:

式中:Sd为算法检测结果中的显著对象的面积; Sg为人工标记的显著对象面积。

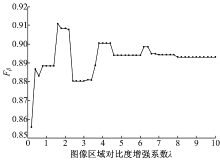

实验1 图像区域对比度增强系数λ 对实验结果的影响如图4所示。本文选用准确率与召回率的调和平均数Fβ 为测试λ 变化时对实验结果的影响。Fβ 的计算公式如下:

在计算准确率和召回率时, 本实验将阈值设定为TH:

式中:M为图像像素总数。

取系数β 2=0.3, 使得正确率的权重高于召回率。Fβ -λ 曲线变化趋势如图4所示。当λ =1.6时, Fβ 取得最大值, 对比度加权算法得到的检测结果最佳; 当λ > 7时, λ 的变化对算法结果影响较小。

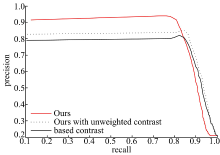

实验2 比较了基于本文对比度特征(Based contrast)的显著性检测结果、本文算法对比度未加权(Ours with unweighted contrast)时的检测结果以及加权后(Ours)的结果。PR曲线如图5所示。

由图5可知:采用多特征融合的方法, 对比度未加权方法检测效果较基于对比度的方法提高了算法的准确率。同时, 当对比度加权与未加权方法比较时, 由于对比度加权原因, 在召回率大于0.83时加权算法较未加权方法准确率低, 但两者误差较小。从算法整体分析, 对比度加权方法整体表现较好。

实验3 比较了目前被引用较多的几种算法与本文算法的检测结果, 同时给出了基于本文对比度特征的显著图(RC_ours), 实验结果如图6所示。与RC11相比, 本文算法不同之处在于:①

本文不仅构建区域对比度特征函数, 同时将空间位置特征引入显著性检测模型; ②本文算法首先去除图像背景区域的干扰, 在前景区域内检测显著对象, 减小了背景区域对检测结果的影响, 增强了对复杂图像的显著性检测能力。本文算法对较复杂背景的图像检测效果较RC11算法有所提高, 结果如图6(e)和图6(g)所示。由于忽略了背景信息, 本文基于前景区域对比度的显著性检测方法会出现较RC11算法不理想的检测结果(见图6(f)列第二幅显著图), 但本文算法融合区域位置信息以及区域面积可以弥补这一不足, 使本文算法能较好地抑制图像非显著性区域, 得到背景干扰较少的显著图, 如图6(g)列第二幅显著图所示。同时, 正如图6(e)(g)列第一幅显著图所示, 本文算法对背景较复杂的图像的检测结果较RC11算法有改进, 在检测显著对象时对背景区域及非显著性对象的显著性有较强抑制, 能较好地突出显著对象。IT98与HA06算法检测的重点是图像中的显著点, 因此显著图中的显著对象较模糊。

实验4 算法PR曲线比较。在显著性检测中, PR曲线能较好地反映算法的优劣[1, 6, 12, 18, 19, 29]。图7给出了不同算法的PR曲线。由图7可知:与RC11相比, 由于忽略了背景信息, 本文未加权的检测方法仅当召回率在[0.6, 0.9]之间变化时算法准确率较佳。而本文对比度加权算法与RC11相比较, 在召回率小于0.87时有较好的准确率; 当召回率大于0.87时, 因对比度加权、忽略背景区域对比度等原因, 导致准确率较RC11算法相比性能下降, 但对于背景较复杂的图像本文检测算法改进效果明显。

本文将提取的显著图应用于显著分割。目前, 该领域研究中基于自下而上的显著区域分割主要有:Ma等[9]通过模糊区域增长方法在显著图中找到矩形的显著区域。Achanta等[29]使用显著图为Graph Cuts算法提供前景与背景区域, 自动分割显著对象。Han等[31]用颜色、纹理和边缘特征构建马尔科夫随机场模型, 使用显著图的种子值来增长显著性对象区域。Cheng等[19]使用召回率为95%时的阈值二值化显著图为GrabCut提供初始化模板, 分割显著性区域。

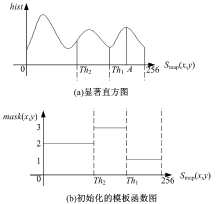

本文通过统计显著图的直方图分布, 利用双阈值方法初始化GrabCut[32]模板, 改善显著对象分割效果。GrabCut[32]算法综合利用纹理及边界两种信息, 通过高斯混合模型和Graph Cuts[33]进行迭代分割图像, 需要人工交互操作选取矩形区域进行初始化。本文依据显著图对GrabCut初始化, 避免了人工交互操作, 可自动分割图像显著对象。由于显著图中显著值的大小反映了图像对应位置的显著性:显著值越大, 其显著性就越高, 因此, 本文在初始化模板时为克服文献[19]使用单个阈值的不足, 使用直方图统计显著图中显著值的分布, 得到显著直方图, 设置不同阈值将显著图标记为显著区域、可能的显著区域、可能的非显著区域来初始化GrabCut。具体而言, 在初始化过程中, 本文设定阈值Th1标记直方图中显著值最大的区域为显著性区域。同时, 为了使提取的显著对象较为精确, 本文将大于显著图均值Th2小于阈值Th1的显著区域初始化为可能的显著性区域, 把小于显著均值的部分初始化为可能的非显著性区域。阈值的选取如图8所示。定义初始化函数为:

式中:1表示显著性区域, 2表示可能的非显著性区域, 3表示可能的显著性区域; Smap(x, y)为图像显著图。

为了保证较好地标签显著性区域, 本文将Th1设定为最大的极小值, 确保显著值的最大区域为显著对象。如图8所示, 初始化显著性区域为[Th1, 256]。其中Th1描述如下:设L1为直方图极大值点对应的显著值ai的集合, ai∈ L1, i=1, …, l1(l1为极大值点个数); L2为直方图极小值对应的显著值bj的集合, bj∈ L2, j=1, …, l2(l2为极小值点的数量)。则Th1需满足如下条件:Th2< Th1< A, 对"j, 有Th1≥ bj, 且Th1∈ L2。其中, A=max{ai}为集合L1中的最大值。图8中hist表示对应Smap(x, y)的统计结果。

初始化之后, 本文迭代运行GrabCut来优化显著性分割结果(在实验中最多迭代两次), 图9(b)列给出了RC11算法的分割结果, 图9(c)列给出了本文提出的新的初始化方法的分割结果。

提出了一种基于对比度、空间位置特征的自下而上、数据驱动的显著性区域检测方法。在进行显著性检测的过程中, 本文提取图像前景区域, 构造的对比度特征函数能较好地计算出不同前景区域对比度对图像显著性的贡献, 结合图像的空间位置特征函数和区域面积能较好地检测区域显著性。同时, 本文提出一种新的初始化GrabCut算法的方法分割显著对象, 并得到了较好的结果。总体而言, 本文提出的算法简单, 且进一步提高了显著性区域检测结果。由于本文方法采用对比度加权以及忽略背景信息, 导致了召回率大于0.9时检测精度不够理想, 但对于较复杂图像的检测, 本文算法有了较大改进。因此, 本文算法是一种有效的显著性检测算法。在将来的研究工作中, 将会考虑结合其他图像显著性特征, 合理整合图像对比度及背景信息, 进一步改善算法的检测结果。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|