作者简介:王玉(1983-),男,讲师,博士研究生.研究方向:图像处理与模式识别,多媒体信息技术.E-mail:wangyu001@jlu.edu.cn

提出了一种在Gabor变换幅值域内提取3个正交平面上的局部二值模式的多角度特征融合的视频人脸纹理表示及其识别方法。首先对视频帧集合中归一化的每幅人脸图像进行不同尺度和方向的Gabor小波变换得到增强的Gabor幅值图谱。然后采用3个正交平面上的局部二值模式提取视频纹理特征。最后采用基于Fisher加权的Chi平方概率统计最近邻方法进行视觉人脸识别。通过在Honda/UCSD视频库进行的相关实验,验证了算法的有效性,该方法对光照变化、表情变化等具有较好的鲁棒性。

A video-based face texture program was proposed, which can extract binary patterns from three orthogonal planes in the frequency domain of the Gabor transform (GLBP-TOP). First, each normalized face was transformed by Gabor wavelet to get enhanced Gabor magnitude map. Then, the LBP-TOP operator was applied to the maps to extract video texture. Finally, weighted Chi square statistics based on Fisher Criterion were used to realize the face classification. The proposed algorithm achieved good results in the Honda-UCSD database, and was effective and robust under changes of illustration and expressions.

视频人脸识别技术近年来成为计算机视觉领域的研究热点和难点, 伴随着物联网、网络安全等的发展, 具有广阔的应用前景。相对于静态图像, 动态视频中可选用的特征信息更加丰富多样[1], 例如, 视频的时间动态信息有助于识别率的提升; 从视频序列中可以选取分辨率相对较高的图像以提高识别性能; 还可以通过视频学习重构目标三维模型, 利用这些模型可以高效地实现目标识别。总之, 时间和运动信息在基于视频的目标识别中具有重要作用。

视频人脸识别方法主要分为两类:一类是设法提取出视频序列中最具代表性的单独人脸帧图像, 采用传统的基于静态图像的人脸识别方法[2, 3], 包括基于几何特征的方法、基于统计的方法等对人脸进行识别。该类方法存在的主要问题是对关键帧的定义较为模糊, 且没有有效利用视频中的上下文信息。另外一类就是将视频看成是一个视频帧集合[4, 5], 从帧集合的角度进行分析, 利用3D建模、时空连续信息的概率模型、设计视频纹理描述等方法提高识别率, 在这类方法中如何充分利用视频中人脸的时间和空间信息克服视频中人脸分辨率低, 光照、表情、姿态变化剧烈等困难是研究的重点。

本文从帧集合的角度出发, 针对如何在低计算复杂度的前提下能够有效表示视频人脸纹理并进行识别的问题提出了一种基于三个正交平面上的Gabor局部二值模式空间的人脸纹理描述及相应的识别方法。实验结果表明:与传统的从图像的灰度空间统计得到的LBP-TOP特征直方图相比, 本文算法通过结合Gabor变换和LBP-TOP算子的独特优势提取出了多角度特征融合的视频人脸纹理特征, 从而有效地增强了特征直方图的表示能力。同时, 本文算法对光照变化、表情变化是鲁棒的, 而且具备较强的可判别能力。

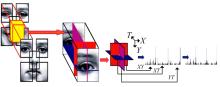

本文提出了多角度特征融合的基于GLBP-TOP的视频人脸纹理表示和识别方法, 该方法首先利用Gabor变换对视频序列中选取出的每个单帧图像提取多方向、多尺度的局部频域特征; 然后通过LBP-TOP算子对这些特征进行编码后统计得到的特征直方图来表示视频纹理, 人脸的分类识别则可以通过特征直方图的匹配来实现。在此基础上, 本文还采用了Fisher准则对人脸不同区域进行统计, 得到权重信息, 以实现加权的直方图匹配策略, 进一步提高了识别精度。算法框架如图1所示, 算法主要步骤如下:

(1)以双眼坐标为基准对从视频中提取的人脸视频序列进行人脸归一化处理。

(2)在预处理阶段, 对人脸视频序列中的每个视频帧进行两个尺度、四个方向的Gabor变换, 得到频域幅值图像, 并对获得的多幅图像进行整合以增强图像幅值特征, 目的就是提取出人脸视频帧中的频域信息。

(3)对Gabor幅值图像集合划分块, 并对每个分块提取LBP-TOP视频纹理特征, 获得每个分块级的局部直方图统计信息, 以获得视频人脸的局部时域-空域纹理信息。

(4)将各个分块级的LBP-TOP特征直方图进行级联操作, 构成整个视频序列的全局直方图, 从而获得视频人脸的多角度特征融合的纹理表示特征。

(5)在分类识别阶段, 采用Chi平方概率统计的最近邻方法, 对待检测的视频人脸序列特征直方图和样本集中的已知人脸特征直方图进行相似性判定, 相对于各分块权重相同的匹配策略, 本文采用基于Fisher准则的加权Chi平方概率统计的识别方法来提高识别精度, 并通过相关的对比实验验证了本文算法的有效性。

通过结合频率域、空间域和时间域中人脸表示的优势, 设计并实现多特征融合的视频人脸纹理表示方法必然会提高视频人脸识别精度。

Gabor小波变换能够提取图像的多尺度、多方向局部频率信息, 可以增强一些关键特征, 在提取目标的局部空间频率域信息方面具有良好的特性。在人脸识别领域中, Gabor变换得到了广泛的应用, 如基于Gabor特征的Fisher判别人脸识别[6]等。

二维Gabor小波函数定义为:

式中:μ 、ν 分别为Gabor核的方向和尺度; z=(x, y)代表图像中的一个像素点; kμ , ν 控制高斯窗口的宽度、震荡部分的波长及方向, ν 的取值决定了Gabor滤波的波长, μ 的取值表示Gabor核的方向。

Gabor人脸可以通过二维Gabor小波函数和人脸图像进行卷积运算得到:

Gabor小波函数与图像的卷积结果是由实部和虚部两个分量构成的复数响应(滤波系数)。幅值比较稳定, 不会随位置产生旋转, 幅值信息反映了图像的能量谱, 因此常被用来进行人脸的特征表示。其幅值表示为:

式中:Re(G(x, y))、Im(G(x, y))分别为G(x, y)的实部和虚部。

这里取m∈ {0, 1}两个尺度, n∈ {0, 1, 2, 3}四个方向的幅值图谱, 并通过如下方法获得增强的Gabor幅值图谱表示:

LBP算子于1996年由Ojala等提出[7, 8], 是一种从纹理局部近邻定义中衍生出来在灰度范围内的纹理度量算子。该算子具有很强的分类能力、较高的计算效率、灰度不变性和旋转不变性的特点。LBP算子计算过程为:定义一个3× 3的窗口, 以窗口中心点灰度值为阈值, 对相邻点的灰度作二值化处理, 然后按顺时针方向将这些值进行加权求和, 得到该窗口中心点的LBP编码值, 计算过程如图2所示。

对于给定图像中的任一像素点, 其LBP编码值可通过如下公式计算得到:

式中:s(x)=

采用双线性插值来计算邻域不在图像网格上的像素点的灰度值。当图像中的每个像素点都统计得到LBP编码值后, 可以建立一个统计直方图用于表示图像的纹理。

通过LBP算子实现人脸纹理描述的基本思想是:将正规化后的正面人脸图像进行若干分块划分操作, 对各分块利用LBP算子构建局部的人脸纹理描述特征直方图, 然后通过把各局部纹理表示级联组合形成全局纹理表示, 从而得到人脸图像空间域上的纹理特征直方图。

人脸识别过程中, 光照变化对识别率的影响很大, 从图3和LBP算子的计算公式(式(5))可以看出, LBP算子具有灰度平移不变性, 即LBP算子对均匀光照变化是鲁棒的。从而, 以LBP算子为基础衍生出的其他算子也都满足这样的特性, 比如描述视频纹理的VLBP算子和LBP-TOP算子。

动态局部二进制模式(VLBP)是在LBP的基础上加入运动特征形成的。VLBP算子提取的是图像中的纹理特征和运动特征, 可用于图像序列的人脸识别。VLBP算子的提取公式为:

在标准的VLBP算子计算中, 不仅包括了当前帧的P个邻域像素, 同时包括了时间间隔为L的前后两帧的P+1个邻域像素, 共计3P+2个邻域像素。参数P决定了特征向量的大小, 当P较小时, 特征直方图维度较低, 同时意味着丢失更多的细致纹理信息; 而当P较大时, VLBP算子二进制位将迅速增加, 直接导致最终得到的统计直方图维度较高, 一定程度上限制了VLBP算子的应用。为了解决上述问题, 提出了LBP-TOP[9]算子, 并在此基础上衍生出多种纹理表示算法[10]。

一个视频序列可以被认为是以时间轴T为中心的XY面的堆叠, 但却忽视了视频序列也可以是以Y轴为中心的XT面的堆叠, 或是以X轴为中心的YT面的堆叠。XT平面和YT平面同样提供了关于时空过渡的大量信息。LBP-TOP算子就是在XY、XT和YT三个正交面上提取级联LBP特征, 统计得到这三个方向上的纹理变化信息。由此, 视频序列在三个方向上的运动和表现信息就都得到了表示, 这其中包括了空间域信息(XY-LBP)和时间-空间域信息(XT-LBP和YT-LBP), 同时, LBP-TOP算子相对于VLBP算子, 在每帧考虑P个邻域的情况下, 可以将直方图维度从23P+2降至3× 2P, 降低了计算的时间复杂度。基于分块级的LBP-TOP算子描述过程如图4所示。

本文采用Chi平方概率统计来度量两个直方图序列之间的相似度。Chi平方概率统计计算公式为:

式中:S、M表示被比较的两个直方图序列; l代表直方图的维度。

按照式(7)可以计算出待检测人脸序列S与每个样本序列M之间的距离, 并通过最近邻分类器(kNN)将S归为距离最小的一类。

构成GLBP-TOP的每个分块级特征直方图对应的是人脸不同区域的纹理变换, 而不同区域的可辨别能力显然应该是不同的, 对人脸的不同区域赋予不同的权值可以反映各个区域的变化规律, 将有效提高识别能力, 则加权相似度计算公式可重写为式(8)的形式:

式中:wj为全局特征直方图的第j个分块的权值。

本文采用基于Fisher准则统计加权的Chi平方概率统计匹配策略, 通过对人脸不同区域特征直方图赋予相应的权重信息来提高识别的精度。Fisher准则[11]的基本思想是通过使类内散度尽可能小, 而类间散度尽可能大来分析每个区域的权值, 用于评估不同人脸区域的辨别能力, 该准则已经得到广泛的应用。对于C个类的分类问题, 同类样本中不同样本之间的相似度分布构成了类内相似度空间; 不同类样本中样本之间的相似度空间形成了类间相似度空间。则每个分块的类内相似度均值和方差可通过如下公式计算得到。类内相似度均值为:

类内相似度方差为:

式中:

同理, 可以得到每个分块的类间相似度均值和方差。类间相似度均值为:

类间相似度方差为:

最终第b个分块的权重可以通过如下公式计算得到:

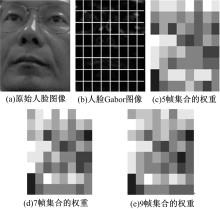

如果某个分块的类内类间相似度均值相差很大而方差又比较小, 那么该分块的统计直方图特征具有更强的识别能力, 一个相应的比较大的权重应该赋值给这个分块; 否则, 该分块的权重则较小。由此, 通过给定样本计算可以得到不同分块的权重。如图5所示, 对Gabor增强纹理图像以8× 8分块处理, 将通过Fisher准则计算得到的权值量化到1和8之间。其中, 暗色区域对应的权值较小, 亮色区域对应的权值较大。

目前常用的视频人脸数据库包括Honda/UCSD数据库和Mobo(Motion of body)数据库等。Honda/UCSD数据库包含20个不同人的视频段, 其中训练集视频20段, 测试集视频39段, 提取的视频人脸图像经归一化后为183像素× 229像素。

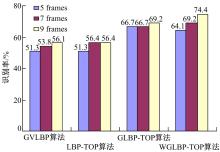

本文分别观察了VLBP、LBP-TOP、Gabor变换幅值的VLBP(GVLBP)、Gabor变换幅值的LBP-TOP(GLBP-TOP)以及采用了Fisher加权准则的GLBP-TOP(WGLBP-TOP)五种不同算法的识别性能。分类器选择基于Chi平方概率统计的最近邻方法。当视频帧集合大小为7帧时, 五种不同算法的参数选择及分类结果如表1和图6所示。

| 表1 不同算法在Honda/UCSD视频人脸数据库上的首选识别率 Table 1 Recognition rate of different algorithms |

在VLBPL, P, R算子描述中, P的大小直接影响到算子提取的特征直方图维度, P越大, 参与计算的邻域像素个数越多, 局部纹理描述更加细致, 但对应的特征直方图维度较高, 所以P不建议取值过大[9]。表1中分别给出了(L=2, P=4)和(L=1, P=4)的情形下算法的识别率。

在LBP-TO

本文算法通过结合Gabor变换和LBP-TOP算子的独特优势提取出了多角度特征融合的视频人脸纹理特征, 从而有效地增强了特征直方图的表示能力。通过在不同时间段采集的测试视频集合中与其他基准算法进行对比, 验证了该方法的有效性。同时, 该方法对光照变化、表情变化等具有良好的鲁棒性。

在本文算法中, 视频帧集合的大小对识别率的影响较大。对Honda/UCSD数据库训练集和测试集中所有人脸视频进行逐帧统计分析发现, 正面人脸持续的平均时间不超过10帧, 超出10帧的人脸会发生3D旋转, 而当视频帧集合过小(如3帧)时, 识别率已经低于50%。所以本文重点考查了当帧集合大小为5、7和9时, 各算法的识别性能。

从表2和图7中可以看出:随着视频帧集合的增大, 可以一定程度上带来较高的识别率, 但时间复杂度也会随之增加。

| 表2 视频帧集合大小对识别率及运行时间的影响 Table 2 Recognition rate and time consumed of different size of frames |

| 图7 各算法选取不同大小视频帧集合的首选识别率Fig.7 Recognition rate of different algorithms with different sizes of video frame set |

本文基于Honda/UCSD数据库对视频帧集合大小对识别率的影响分析进行了大量实验, 对GVLBP、GLBP-TOP这两种性能较好的算法进行的统计分析的实验结果如图8所示。

| 图8 GVLBP和GLBP-TOP算法在不同大小视频帧集合的CMC曲线Fig.8 The CMC of different sizes of video frame set by GVLBP and GLBP-TOP algorithms |

从图8可以看出:随着视频帧集合的增大, 可辨别性信息的增多, 识别性能在一定程度上得到了提高, 但可辨别性信息增多的同时, 视频帧带来的噪音等影响识别率的因素也随之增多, 在不同环境下的实际应用中应兼顾性能和时间复杂度。

由于采用了Gabor小波、LBP-TOP算子的特征直方图等兼顾局部特征变化和全局视频特征分布的多角度特征融合的视频人脸纹理表示及识别方法, 因而对光照、表情变化等问题具有较高的鲁棒性。从视频帧集合的角度考虑进行人脸描述及识别可以有效地利用时空连续性信息, 提高识别精度, 但带来的噪音等影响识别性能的因素也同时增多, 另外, 最近邻分类方法的效率还有待提高。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|