作者简介:于德新(1972-),男,教授,博士生导师.研究方向:交通信息处理,交通系统分析.E-mail:ydx@jlu.edu.cn

首先,利用Hough变换估计出道路长度。然后,利用模糊技术估计出车辆长度。最后得出车辆的空间占有率。采用OpenCV在VC++6.0环境下进行仿真实验,结果表明:该方法能够准确地估计出道路上车辆的空间占有率。

A space occupancy estimating method based on remote sensing images is proposed.First,Hough transform is used to estimate the length of the road.Then, fuzzy processing technique is applied to estimate the length of vehicles.Finally, the vehicle space occupancy is estimated.Simulation experiments are carried out using OpenCV under VC+ +6.0 environment. Simulation Results show that the proposed method can accurately estimate the vehicle space occupancy on the road.

目前交通信息采集方法众多, 如地磁、感应线圈、微波、GPS/GIS等, 但是受成本、外界环境等条件的影响, 都不能有效、全面地采集交通信息。近来随着数字图像处理技术的迅速发展, 遥感图像处理技术在交通领域得到广泛的研究和应用。基于遥感图像的交通信息采集方法, 可以改变目前道路交通信息采集成本过高的现状, 并且能够采集大范围路网上的交通信息[1]。从遥感图像中提取出的密度、速度、交通流量等信息能反映出道路的拥挤程度, 其中车辆的空间占有率是交通状态判别的重要依据。

遥感图像以获取简单、成本低以及道路交通信息充足的优点, 成为相关交通研究者研究的热点。但是目前的研究[2, 3]大多是针对遥感图像中的道路信息进行提取, 未实现对道路车辆空间占有率的有效计算。由于遥感图像具有模糊性和复杂性, 而模糊技术能处理不确定性中的模糊性, 所以模糊技术在遥感图像处理中得到了广泛的应用。目前大多文献是利用模糊技术对视频图像进行处理, Pal等[4]利用模糊技术进行图像的增强处理; Russo[5]总结了基于模糊模型的非线性过滤器方法; 王保平[6]利用模糊技术对图像进行边缘检测。Hough变换[7]是20世纪70年代提出来的方法, 目前广泛地应用于图像处理中的边缘检测。

综上, 本文选用遥感航空数据, 采用Hough变换估计所选路段的长度, 并采用模糊技术估计遥感图像中的车辆长度, 最后计算出车辆的空间占有率。

从遥感图像中初步提取车辆后, 选用Hough变换对有车路段拟合出一条直线, 这条直线的长度就是所选路段的长度。

首先对遥感图像进行预处理, 包括图像分割、图像增强、开闭运算等[8, 9, 10, 11, 12]; 然后进行特征提取来初步提取出车辆。一般图像增强方法可以分为频域法[13]和空域法[14]两大类:频域法是在图像的变换域中进行某种滤波处理; 空域法是基于灰度级的映射变换, 直接处理图像中的像素, 本文选择空域法。本文采用自适应中值滤波器[15]对遥感图像进行去噪处理。特征提取技术先后经历了Moravaec[16]、Harris[17]、SUSAN[18]角点检测方法, 本文选择Harris角点检测方法对车辆进行特征提取。

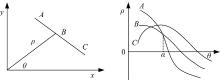

Hough变换算法主要是利用直角坐标系与极坐标系之间的转换来实现直线和较为规则曲线的拟合[4]。它的基本原理是:在图像中一定位置上的曲线或者直线上所有可能的点一般都能对应到极坐标中一个标准的点上, 然后经过统计分析得到所求边缘点的最大值。在一般的直角坐标系中, 数字图像中任何一个像素点都可以被具体公式表示出来。直线位置的斜截式以及极坐标表达式分别如式(1)和(2)所示:

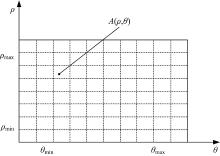

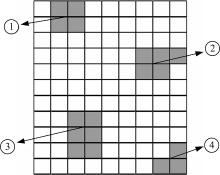

将直角坐标系中任意一点放置在极坐标系中都是一条正弦曲线, 在直角坐标系中同一条直线上的所有点在极坐标系一一对应的曲线会相交于一点, 如图1所示。Hough变换有在极坐标系中能凝聚在一起形成最高点的特点。因此可以通过搜寻极坐标系中的最高点来辨别出直线。由于Hough变换采用的是各点累加的方法, 所以如果车道线出现间断时, 该部分只能影响局部的数值。假设直角坐标系中的点为(x, y), 转换成极坐标为(ρ , θ ), 那么Hough变换可用式(2)表示。Hough变换参数提取过程如图2所示。

(1)如图2所示, 基于参数坐标系

(2)把这个二维数组进行初始化以后, 按照排列的顺序来找到图像中全部所需白点, 而有关图像中的全部白点, 将

(3)详细记录变换域中求出的最大值, 并依照一定的顺序排序。

(4)对最大值点以及附近全部点进行清零。

(5)按顺序求出最大值点并记录下来。

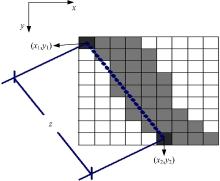

Hough变换的原理是从二值化的图像中拟合出车辆堆积到一起的直线, 将遥感图像进行Hough变换, 得到的直线端点的像素值都为1。Hough变换得到直线的一端为起点, 沿着直线依次检验所有图像的像素值的大小。如果一个元素连续不断, 那么这个点为车辆元素, 如果一个元素连续不断的值为0时, 则这个元素排除, 最终沿着直线得到连续不断的像素值大小为1的像素的数量就是所要计算的道路的长度。

所以该方法能有效地提取道路长度, 同时该方法在车辆分布规则的情况下十分有效, 而且遥感图像越清晰, 最后得到的结果越好。

道路长度计算的具体过程如图3所示, 图中每一个方格的大小代表图像的像素大小, 灰色的方格为路的元素, 取出路段两侧边缘上两个点, 坐标分别为

式中:

假设论域为X={x1, x2, x3, …, xn}, 其中属于它的元素用x来表示, 那么X的子集A能用一种特殊的函数

式中:iff为当且仅当的意思; {0, l}为赋值的集, 若能把赋值的集扩大成闭合的区间[0, 1], 那么把

模糊集合有各种不同的表示方法, 在一般情况下, 可以将其表示为:

式中:X为论域, A'为论域中的一个模糊集合。

相对于模糊集, 定义其隶属度函数的方法有多种。对于同一个论域的模糊集合, 不同的人有不同的评判标准, 最后得到的每个元素的隶属度一般也不相同, 而且不一样的隶属度函数结构又使这个模糊集合的模糊性不同。为了能合理地衡量模糊集合的模糊性大小, 这里引进模糊熵的定义。基于模糊熵的概念, 依据所描述图像的实际模型结构, 定义一个与图像相关的模糊熵。

假设

将图像像素的灰度值大小作为论域。基于论域建立一个模糊集, 并且将其看作同样大小的模糊图像集, 最后给出图像隶属度函数的计算公式:

式(7)表示窗口

基于以上给出的概念和定义, 针对该图像的模糊集, 选定一个模糊熵量化图像的模糊特性。具体的计算公式为:

式中:

如果所用窗口灰度值与窗口中心(i, j)位置的灰度值x(i, j)相等或接近时, 则模糊熵e(A')较小或者为0; 反之, 模糊熵较大。倘若(i, j)的像素值较为平缓, 那么该窗口的灰度值会在一个水平线上, 而其余的灰度值均接近中心处的灰度值x(i, j), 则e(A')较小; 反之, 当窗口中心(i, j)处于图像的边缘点及灰度值跳跃点时, 窗口区域的灰度值差异较大,

基于模糊技术精确提取车辆的方法步骤:首先初步从遥感图像中对车辆进行提取后, 根据车(包括小型车、中型车、大型车, 这里取每种车型各10辆)的遥感图, 计算出这30辆车的模糊熵的平均值

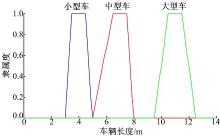

当检测出全部的车辆元素时, 由于遥感图像的复杂性和模糊性, 而且检测车的车辆元素存在一定的误差, 下面利用模糊技术来区分小型车、中型车和大型车。依据式(7)本文定义以下3种车型的隶属度函数, 其中

小型车的隶属度函数为:

中型车的隶属度函数为:

大型车的隶属度函数为:

通过比较

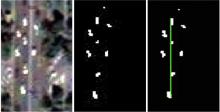

在OpenCV在VC++6.0的环境下进行仿真。一般Hough变换是拟合道路直线的, 由于本文只估计有车路段的车辆空间占有率, 所以利用Hough变换来估计道路的长度。图4为利用Hough变换拟合的结果。

从遥感图像中对车辆进行初步的提取后, 再利用模糊技术可以从遥感图像中对车辆进行比较精确的提取, 最后得到平滑的道路上的车辆元素, 连续为1的图像元素是一个车辆元素, 如图5所示, 可以判断该图有4个车辆元素。

利用式(3)粗略地计算每辆车的长度l。图6为小型车、中型车、大型车的隶属度图。

利用式(10)(11)(12)计算小型车的隶属度

道路的车辆空间占有率是车辆的总长度与路段的总长度的比值, 车辆密度一般只能描述道路上交通流的密集程度, 但是空间占有率可以用来描述路段上车辆占有率的大小, 如式(13)所示:

式中:Rs为车辆空间占有率; li为第i辆车的长度。

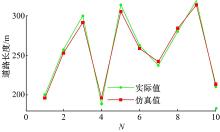

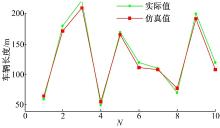

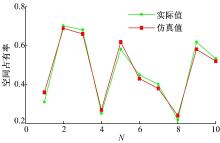

为了进一步验证本文方法的有效性, 选取10张遥感图, 用本文方法进行处理, 把得到的道路长度、车辆长度、空间占有率与实际值作比较, 结果如图7~图9所示, 图中,

从图7可以看出, 利用Hough变换估计的道路长度与实际相差很小。从图8和图9可以看出, 利用模糊技术估计的车辆长度以及空间占有率的误差都低于7%, 证明了本文方法的有效性。

采用模糊技术估计车辆的长度, 采用Hough变换估计道路的长度, 实验结果证明本文方法能够有效地估计出道路车辆的空间占有率。由于不同遥感图像的清晰度存在一定的差异, 从不同清晰度的遥感图像中精确地计算出车辆空间占有率的技术还有待进一步研究, 而且从遥感图像中提取车辆速度也是下一步研究的难点和重点。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|