作者简介:陈强(1981-),男,博士研究生.研究方向:车辆可靠性与安全技术.E-mail:qf_chenqiang@163.com

为了解决道路交通事故现场二维勘测中“四点法”的不足和实际应用问题,提出了基于小型无人机摄影测量的“改进四点法”。首先,通过小型无人机拍摄事故现场图像;其次,对事故现场图像采用预先对控制点信息进行归一化处理的方式减少校正过程中病态矩阵求解问题;然后,调用图像校正算法将透视图校正为正投影图;最后,以校正后的正投影图为依据,调用图像量测模块在新的正投影图上进行测量、记录和标注。通过控制场地测试和典型交通事故案例现场测试验证了该方法的有效性。与传统人工测绘以及图像测量方法相比,该方法在提高事故现场勘测精度的同时,扩展了勘测现场范围,抑制了拍摄角对“四点法”精度的影响。

In order to solve the deficiency and limit of using “4-point photogrammetric method” in 2D surveying of traffic accident scene, an improved 4-point surveying method was proposed, which was based on Small Unmanned Aircraft Vehicle (SUAV). First, the traffic accident scene images are capture by SUAV. Second, the captured images are transmitted back to the image pickup device immediately, and a pre-normalized approach for control point information processing is applied to reduce pathological situation of matrix calculation in the correction process. Then, the image correction algorithm is employed to rectify the perspective image to orthographic image. Finally, an image measuring module is used to measure, record and mark the information on the basis of the orthographic image. A control field test and an accident cased were used to validate the proposed method. Compared with the traditional manual surveying and photogrammetric method, the proposed method can not only improve the accuracy of accident scene surveying, but also expand the scope of the investigation, and constrain the impact of project angle on the accuracy of 4-point photogrammetric method.

传统的交通事故现场勘查方法, 首先采用皮卷尺测量相关距离, 然后手工绘制现场草图及现场比例图。这需要占用事故现场路段、中断交通, 容易诱发二次交通事故, 且存在费时长、现场信息遗漏多、勘测精度低, 现场量测的数据和绘制的草图因操作者存在差异, 以及恢复交通后无法对现场复查勘测等缺陷, 给事故责任判断造成很大麻烦[1, 2]。在交通事故现场拍摄的照片(图像)中包含有现场大量信息, 如车辆停止位置、制动拖印、轮胎印迹、油污迹、碎片散落分布位置等[3, 4]。因此, 国内外出现了大量不同形式和复杂度的采用摄影测量技术分析车辆和现场信息的研究成果, 以便快速、精确地获得交通事故现场的重要信息, 用于交通事故现场的重建。目前, 为了实现摄影图像校正测量, 出现了一些商用软件, 如PC-RECT、PhotoModeler、iWitness和123D Catch等[5, 6, 7, 8, 9]。这些软件提供一系列鲁棒好的摄影图像测量分析。其中, 频繁用于交通事故现场重建的“ 平面到平面” 的二维校正算法, 是计算机视觉算法领域的重要分支[10, 11, 12, 13], 可用于一般平面现场数据的测量。二维校正算法假定图像上的点都清晰地位于空间中的同一平面上, 使用单张照片采用“ 四点法” 重建事故现场。该方法具有简单、快捷和信息易于保存等优点, 但是其勘测精度受摄影角度、摄影位置的影响较大。校正误差与摄影倾角密切相关, 倾角越小, 相同像点误差造成的实际校正误差越大。理想的拍摄角度应垂直于地面[14], 这在采用普通相机人工拍摄方法中实际上无法达到。

近来, 小型无人机(Small unmanned aircraft vehicles, SUAV)摄影测量技术迅速发展[15], 在大比例尺地形图测绘领域得到了广泛应用。而且, 其携带的摄像头可以满足《道路交通事故现场勘验照相》(GA50-2005)关于成像分辨率的要求。本文结合无人机摄影测量技术对“ 四点法” 进行改进, 通过无人机拍摄事故现场图像, 然后对控制点信息进行归一化处理以减少计算中的病态问题, 再将透视图校正为正投影图, 最后在校正后的正投影图上进行测量、记录和标注。通过控制场地试验测试和典型交通事故案例测试验证了该方法的有效性。

假定图像上的点都位于空间中的同一个平面上, 仅单张照片就可重建交通事故现场。当图像中4个任意三点不共线的参考点的像素坐标及其在空间平面上的坐标已知时, 就能够确定图像上的点和空间平面上的点的一一对应关系[16]。

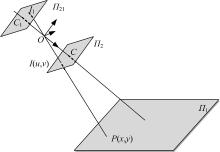

所有景物通过摄像机光轴中心点投射到成像平面上的摄像机模型, 称为小孔模型[12]。如图1所示,

对点

射影变换是射影平面上的可逆齐次线性变换, 可由3× 3的矩阵来描述:

式中:矩阵

由于变换是齐次的, 所以同一个射影变换矩阵

将式(1)的第一行、第二行分别除以第三行, 解得:

对式(2)化简、移项, 得:

求解射影变换矩阵

假定向量

根据式(3), 有:

由方程(4)对物点

实际计算时, 物点

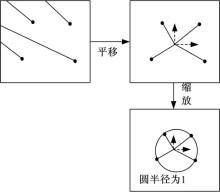

将所有点的中心作为原点, 构建坐标系, 利用式(5)把每一个点的坐标转换为在该坐标系下的坐标:

式中:

假设像点

采用各向同性缩放保持坐标点坐标变换的一致性, 使每个点到上述平移变换坐标原点的平均距离等于

缩放变换后各点的坐标为:

上述计算过程经空间坐标变换恢复了像点

RGB图像使用3个一组的数据表达每个像素的颜色, 即其中的红色、绿色和蓝色分量[18]。通过图像像素值的映射, 为每个点赋予RGB图像各颜色分量的灰度值, 可实现校正图像的输出。

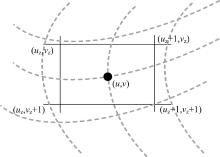

本文综合考虑计算速度和插值效果, 采用双线性插值法进行校正图像输出, 将输出像素逐个映射回输入图像中。如图3所示, 输出图像点的像素值为输入图像中距离它最近的2× 2邻域内4个点的像素灰度值的加权平均值。

假设校正输出图像中的任意一点

为了达到更好的输出效果, 也可以采用双三次插值方法计算输出图像的像素值。

通过以上论述, 将改进的四点法总结如下:

(1)在空间平面

(2)运用式(5)(6)(7)对选择的上述4点做归一化处理, 处理后点的坐标为

(3)运用式(4), 采用归一化处理后的坐标求解向量

(4)由向量

(5)运用式(1), 由矩阵

(6)运用式(5)(6)(7)对上述计算的物点

(7)运用式(8)计算输出图像中各点的像素值, 输出校正图像。

(8)在输出的校正图像上提取待测点, 测量所需距离信息。

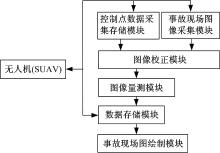

小型无人机具有4个呈十字形交叉结构的螺旋桨, 携带焦距为11.9 mm, 分辨率为1600× 1200像素的高清摄像头, 如图4所示。它可以垂直起降, 也能实现空中悬停, 同时能将空中画面实时传回控制终端。基于此方法的交通事故现场勘查系统构成如图5所示。

为实现上述方法, 以Matlab软件[19]编写了应用程序ImAR, 其所运行的电脑配置为:处理器为Intel(R) Core(TM) i3-2350M CPU 2.30 GHz, 内存为2.00 GB, 操作系统为Win7 64位操作系统。

采用由上述改进的四点法、SUAV和ImAR软件程序构成的系统, 分别对实验控制场和交通事故现场进行数据测量试验, 与普通数码相机采集图像进行数据测量相对比, 验证本方法在交通事故现场勘测中的优势。普通数码相机为Canon PowerShot A480, 焦距为40 mm, 分辨率为1600× 1200像素, 图像大小为2 MB。普通数码相机的拍摄高度为1.5 m, SUAV的拍摄高度为15 m。

选择包含有边长为60 cm正方形瓷砖的地面区域建立控制场。用于数据对比分析的相邻瓷砖的交点已经用数字标出, 并且两幅图像中相同的点用同一数字标识, 点“ 0” 为原点, 其坐标设置为(100, 100), 点“ 0→ 6” 的方向为y轴方向,点"0→4"的方向为x轴方向。使用普通数码相机和SUAV拍摄的图像如图6所示。控制场中各点的坐标如表1所示。

| 表1 控制场各点坐标及对应的像素坐标 Table 1 Coordinate and pixel of each control point |

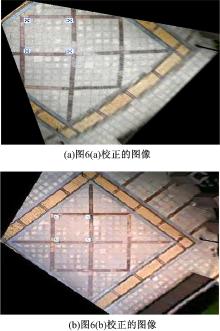

图6中0、1、2、3号点选为控制点, 0~6号的所有点为待测点, 分别对图6(a)和图6(b)做图像校正, 校正后的图像如图7所示。

在改进的四点法计算过程中, 控制点经归一化处理后, 图7(a)和图7(b)的系数矩阵分别为

选择待测点之间的距离值做比较, 计算值、误差和平均误差如表2所示。

| 表2 待测点之间的距离和误差 Table 2 Distance and error of points |

由图7可见, 使用SUAV拍摄的图像校正后包含的控制场有效区域扩大, 校正失真小, 图像输出效果好; 而使用普通数码相机拍摄的图像校正后控制点2、4、5、6号点周边包容区的图像严重失真。

由表2可见, 使用SUAV拍摄的图像校正后待测目标距离的计算值最大误差为0.80%, 平均误差为0.38%; 作为对比, 使用普通数码相机拍摄的图像校正后待测目标距离的计算值最大误差为6.04%, 平均误差为2.53%。使用SUAV拍摄的图像校正后待测目标距离的计算值更精确, 平均误差更小。使用普通数码相机拍摄的图像校正后, 与控制点距离近和在现场标定区域内的点之间的距离的计算值平均误差小, 如0和1号点、1和2号点; 在现场标定区域外内的点之间距离的计算值平均误差大, 如4和5号点、6和0号点。所以, 使用SUAV拍摄控制场的图像, 用于校正, 其待测目标的距离的计算精确度优于使用普通数码相机拍摄的情况, 而且标定区域以外的现场也可以得到有效校正。

图8所示的照片为发生于2014年某日某时的交通事故。车辆在路面留下两条制动痕迹。在事故现场待测区域周围置放标定物后, 操纵SUAV从距离地面20 m的空中拍摄现场照片。本案例测量的主要目标是包括车辆停止位置和制动痕迹长度的现场, 以便于分析车辆制动初速度等事故信息。

为了便于分析比较, 该案例同时采用人工测量方法和“ 改进四点法” 进行事故现场勘测。“ 改进四点法” 对交通事故现场照片进行校正后的图像如图9所示。

在事故现场校正图像中, 标出了制动拖印长度、车道宽和车辆与路边的距离等信息。由图9可看出, 校正后的图像失真小, 各标定物外延区域也得到了较好的校正。人工测量方法与本文方法的主要测量数据对比如表3所示。

| 表3 本文方法与人工测量方法的对比 Table 3 Comparison of measurements between the hand-on method and proposed method |

由表3可见, 与人工测量方法相比, 本文方法的测量结果相对误差在4%以内, 完全能够满足交通事故现场勘查的要求, 可提高交通事故现场摄影勘测精度, 证明了采用SUAV由“ 改进四点法” 进行道路交通事故现场勘查的可行性。

采用普通数码相机运用“ 四点法” 勘查交通事故现场时, 相机的拍摄角度小, 拍摄场景前小后大, 远处目标模糊, 由此带来图像校正精度低、场景覆盖面小、可用信息恢复少等缺点。本文提出了基于小型无人机摄影测量的“ 改进四点法” 。该方法采用预先对控制点信息进行归一化处理的方式来减少图像校正过程中病态矩阵计算的影响, 提高了图像测量算法精度。在此基础上, 通过编写程序对空中摄影图像进行二维校正、测量、记录和标注。通过控制场试验和典型交通事故案例分析验证了该方法的有效性。与使用普通数码相机手持摄影测量的方法相比, 使用该方法进行交通事故现场勘查不但可以在单幅图像勘测中扩展勘查范围, 有效抑制拍摄角度对“ 四点法” 的影响, 而且还能提高事故现场勘查的精度, 增强其实用性。

小型无人机摄影测量用于交通事故现场勘查也有一定的局限性。SUAV在大风、雨、雪和雾等极端天气条件下使用, 其稳定性和精度受影响较大。同时, 为了提高事故勘查的精度, 需要预设地面标志物, 将已知参数标志物布设在待测区域周围, 并且在拍摄的图像中能够识别。如校正图像(图9)中, 距离标定物越远, 数据测量误差越大, 最上部车道宽度已变成346.64 cm, 相对误差为6.7%。这些都是下一步将要解决的问题。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|