作者简介:吉淑娇(1978-),女,讲师,博士.研究方向:视频图像处理,电子稳像.E-mail:shujiaoji@163.com

针对特征点在前景运动物体上会严重影响运行矢量准确性的问题,本文提出利用特征点分类的方法,通过计算KLT跟踪特征点,计算运动估计所得匹配点跟踪所得特征点之间的距离,并由MSAC算法不断更新前景特征点和背景特征点集,最后仅采用背景上的特征点进行全局运动估计,从而进行稳像。实验结果表明,本文方法稳像后视频平滑度更高,而且本算法的无定义区域明显减少,更利于人眼视觉感受。

The objective of this paper is to stabilize electronic image for aerial video with dynamic background. When shooting, as the camera follows the target, the video sequence changes scenarios. This is due to the movement of the camera and the change of background, so the scene is complicated. The difficulties in stabilizing video image with dynamic background include: an accurate estimate motion vector of camera movement and background compensation. To overcome such difficulties, this paper uses KLT track operator in combination with the M-estimator Sample and Consensus (MSAC) algorithm to realize feature point classification. Then, only the feature points on the background are used for global motion estimation to perform image stabilization. Experimental results demonstrate the feasibility of the proposed method.

视频稳像是近年来国内外学者研究的热点, 尤其对摄像机自身有运动, 且场景也发生变化的视频。在运动背景下进行视频稳像, 难点在于如何有效消除前景运动物体带来的影响[1]。在提取特征点算法中, 特征点会落到运动前景物体上, 这种情况会给全局估计带来误差, 很多文献采用RANSAC算法进行特征点提纯, 但解决效果不佳, 国内外学者也做了各种尝试, Ryu等[2]采用直接对原始的和平滑后的特征点轨迹进行估计和校正运动失量的算法, 实现在线的视频稳定, 特征点的轨迹由特征跟踪算法获得, 此算法鲁棒性好, 且不产生累计运动估计误差; 文献[3]利用改进运动矢量估计法进行稳像, 算法实时性强, 但是没区分前景和背景特征点; Kim等[4]采用KLT特征跟踪的方法, 利用背景特征点进行稳像, 取得了很好的结果; 朱奇丹等[5]利用海天线稳像算法解决了船载采集视频的抖动问题; Choi等[6]采用K均值聚类将局部运动矢量场分类为前景运动和背景运动, 并对背景局部运动矢量取模值提取中间值作为帧间全局运动矢量, 本文在文献[4]的基础上, 研究基于KLT进行特征点跟踪, 并采用MSAC算法获取背景特征点并进行运动矢量估计, 最终通过运动补偿实现稳像。

KLT算法[7]是一种典型的特征点跟踪方法, 这种跟踪主要是利用帧间的连续性信息进行的。KLT特征点提取算法的主要思路是通过检验2× 2对称梯度矩阵δ 的特征值来实现特征窗口的定位, δ 矩阵为:

式中:Ixx=

特征点的确定可以通过计算δ 的两个特征值λ 1和λ 2来确定, λ 1和λ 2的计算公式见式(2):

如果λ 1和λ 2都很小, 说明图像具有相对恒定的灰度分布; 如果其中一个很小而另一个很大, 说明图像窗口具有不定向的纹理模式; 如果λ 1和λ 2都很大, 则代表了角点、椒盐纹理或其他能被可靠跟踪的纹理模式[7]。因此, 设定阈值T, λ 1和λ 2需满足:

通常情况下, 阈值T设置为:

式中:λ max为δ 的最大的特征值, 通过这种方法, 可以从参考帧中选取好的特征点。

KLT匹配算法采用图像灰度差的平方和作为特征点的匹配准则, 利用基于最优估计的策略进行特征点之间的匹配, 算法相对较简单, 无需搜索, 耗时少, 可以有效地提高电子稳像的实时性。

对于一副灰度图像, 假设一个具有纹理信息的特征窗口w, 采用平移模型来表示特征窗内的像素点之间的变化, 设t时刻对应的一帧图像表示为I(x, y, t), t+τ 时刻对应的图像帧可以表示为I(x, y, t+τ ), 它们的位置满足:

I(x, y, t+τ )=I(x-Δ x, y-Δ y, t+τ ) (5)

在I(x, y, t+τ )的每个像素点, 都可以由I(x, y, t)中的特征窗口w的像素点平移d=(Δ x, Δ y)获得。

KLT算法的最终目的是找到使SSD最小的ε 值。令SSD值用ε 表示, 利用公式(6)求解:

当位移矢量很小时, I(x+dx, y+dy, t+τ )可由一阶泰勒公式展开:

或者表示成矩阵形式:

式中:

gT=

It=

所以式(6)等效为:

式(8)去掉高次项, 然后对d进行求导, 最终化简得:

式中:

Z=

e=-τ

解方程(10), 即可求得偏移量d。

利用上述KLT匹配算法, 不但可以降低匹配过程中的搜索范围, 减小匹配时间, 而且具有较高的匹配精度。

本文采用KLT提取特征点, 并结合MSAC提取背景特征点。首先定义一些要提取背景特征点所需要的函数。定义由KLT算法在第i帧提取的特征点集合为:Pi={Pi(j)=(xj, yj), j=1, 2, …, N}; 定义

式中:Pi+1(j)=Φ (Pi(j)), 为第i帧图像中的特征点, 采用跟踪算法在第i+1帧中获得的匹配点对。利用匹配点对, 就可以获得运动估计参数矩阵M。

在跟踪过程中, 由于前景目标或者相机的运动可能导致有些特征点在几帧之后越来越少, 甚至消失。这时, 这些特征点就会从Pi, Pi+1中排除掉。这样, 如果在Ci有充足的特征匹配点对, 就可以获得更准确的全局运动估计。如果场景变换剧烈, 引起在参考帧中的特征点找不到相应的匹配点对, 也就是第i帧中的特征点数目小于预先设定的阈值时, 匹配点对也相应减少。这时候, 就会重新选取新的参考帧, 提取好的特征点, 重新定义前景特征点和背景特征点。

很多文献采用随机抽样一致性RANSAC来进行特征点提纯, 但是当前景物体占有整个图像一大部分时, 这种方法效果不好。本文利用MSAC[7, 8, 9](M-estimation sample consensus)结合欧式距离进行背景特征点的获取, 并计算准确的运动矢量。MSAC是算法的一种优化变形方法。RANSAC是基于特征匹配的一种典型匹配对提纯算法, 能够较好地进行误匹配点对的剔除, 其消耗函数的计算过程为:

式中:n为初始匹配集合中所有的匹配点的数目; σ 为当前的匹配点是“ 内点” 的概率, 在实际的应用中依据匹配方法的正确率, 将σ 设置为一个保守值。

MSAC通过修改RANSAC的消耗函数, 从而优化其性能[11]。MSAC运用回降最优估计方法。对于外点仍然赋予同样的值, 内点要根据适应数据的程度得分, 而不是像RANSAC赋予0值, 成本函数为:

文献[12]比较了MSAC和RANSAC算法, MSAC不需要额外的计算消耗。所采用消耗函数本身就可以直接运用最大残余的饱和点和最小二乘法相比, 从而抑制极端异常值的影响。

以6参数仿射变换为例, MSAC算法的步骤是:

(1)从KLT跟踪算法获得的匹配点对Ci={ci(j)=Pi(j), Pi+1(j), j=1, 2, …, N}中, 任选3对特征点对, 运用6参数模型计算运动估计参数M的参数;

(2)计算其余K-3个特征点由M矩阵做仿射变换得到的对应匹配点, 与KLT匹配所得到的特征点之间的距离为d(Pi(j)), 计算公式为:

式中:TM(· )是由第一步计算所获得的几何变换矩阵M所得到的特征点, Φ (Pi(j))为KLT跟踪所获得的匹配点对, ‖ · ‖ 为L2范数。

(3)若距离小于某个阈值范围, 则候选特征点为内点, 形成新的集合

(4)重复执行步骤(1)(2)(3)固定的次数;

(5)利用新的匹配点集合

将一副W* H图像I(x, y)分为两个互不重叠的区域, 定义前景区域为RF, 背景区域为RB, 它们的关系为:I=RF∪ RB。RF为满足条件下边的像素集合:

式中:0< α < 0.5, 用来决定前景和背景区域的大小。

在下一帧中, 特征点为前景还是背景的分类方法如表1所示。具体更新过程中, 采用两个不同的阈值τ 1, τ 2来更新特征点在下一帧中的状态, 从而确定特征点的分类结果。不管下一帧的状态怎样, 当前帧中的特征点不会发生很大程度的变化, 在当前状态上和距离有关的阈值要有选择地选取。也就是说, 对于背景特征点要选择小一些的τ 1值, 对于前景特征点要选择大一点的τ 2值。这样, 如果特征点在当前帧准确分类, 那么大多数特征点可以在下一帧保持它的状态。总结来说:式(18)能更好地说明状态分类的情况。

| 表1 特征点分类示意 Table 1 Schematic of feature points classification |

步骤1 利用KLT算子提取参考帧特征点Pi, 并根据式(14), 设α =0.2, 分别指定背景特征点集

步骤2 KLT进行匹配, 获得匹配点对集合Ci, 任取

步骤3 更新特征点:利用式(16)计算欧式距离d, 根据设定的阈值τ 1, τ 2的值以及式(18)更新下一帧的特征点

步骤4 利用背景特征点

步骤5 对变换矩阵组成的矩阵组, 进行Kalman滤波;

步骤6 运动补偿。

本实验的计算机采用Intel奔腾处理器, CPU主频为2.90 GHz, 内存为4 GB。一个视频为MATLAB库里自带测试视频, 共162帧, 大小为320× 240像素, 另一个视频来自美国空军视频数据库VIRAT[11], 720× 480像素, 两个视频都具有前景运动物体车辆, 背景也较为复杂, 视频如图1所示。

实验一:背景特征点提取图示

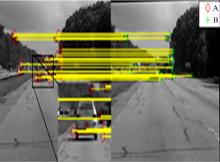

图2为采用KLT提取特征点图示, 没有利用MSAC滤除背景特征点, 即分布在车身上的特征点还很多, 这样必然影响到运动矢量计算的准确度。

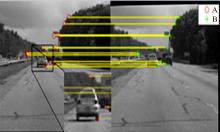

图2的右图为运动补偿后的稳定帧, 虽然稳像前和稳定后的补偿帧能完全匹配, 但是匹配点对的连线稍有倾斜, 说明两帧之间含有运动分量[7]。图3为采用本文算法后, 车身上特征点基本都滤除掉。图3的右图为运动补偿后的稳定帧, 这时稳定帧和原视频帧完全匹配, 且匹配点对的连线为直线, 说明稳像效果很好。

实验二:稳像结果

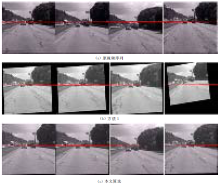

本文利用稳像前和稳像后的视频对应帧进行对比, 并将本文算法和MATLAB自带的基于特征点进行稳像的算法(简称方法1)进行了对比, 效果如图4和图5所示。方法1中稳像后序列的“ 无定义区” 范围较大, 且只处理灰度图像, 本文算法“ 无定义区” 明显小很多, 且根据红色直线标记, 利用本文所提出算法取得了较好的稳像效果。

实验三:效果评价

常见评价方法为PSNR[12, 13]法, 在其基础上, 定义DITF为稳像后相邻帧PSNR的绝对差。此方法适合于动态背景下视频稳像结果的评估[14, 15, 16, 17], DITF计算式如(19)所示。DITF越小, 稳像效果越明显。

DITF是稳定效果评价的方法之一, 本文比较稳像前、后方法1和本文方法的平均DITF结果, 如表2所示, 本文方法的DITF值最小, 说明稳像后视频更平滑。

| 表2 平均DITF对比 Table 2 Comparision of mean DITF |

针对特征点在前景运动物体上会严重影响运行矢量的准确性的问题, 本文提出利用特征点分类的方法, 通过计算KLT跟踪特征点, 计算运动估计所得匹配点跟踪所得特征点之间的距离, 由MSAC算法不断更新前景特征点和背景特征点集, 最后只采用背景上的特征点进行全局运动估计, 从而进行稳像。本文算法与方法1的稳像算法平均DITF对比结果表明, 本文方法的稳像后视频平滑度更高, 而且本文算法的无定义区域明显减少, 更利于人眼视觉感受。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|