作者简介:朱叶(1989-),女,博士研究生.研究方向:图像盲鉴别.E-mail:zhuye13@mails.jlu.edu.cn

针对目前复制-粘贴篡改盲检测算法对光照变换操作鲁棒性较差的问题,提出了一种基于混合灰度序模式(Mixed Intensity Order Pattern, MIOP)的复制-粘贴篡改盲鉴别算法。首先,对待检测图像提取高斯差分区域(Difference of Gaussians, DOG)。其次,利用MIOP特征描述区域。最后,匹配特征并利用RANSAC (RANdom SAmple Consensus)去除误匹配,确定图像的复制-粘贴篡改区域。实验结果表明:本文算法不仅对几何变换和光照操作的检测率较高,且对高斯模糊、噪声和JPEG重压缩等后处理操作鲁棒性较好。

In order to solve the low robustness of copy-move forgery detection with illumination change, a novel method based on Mixed Intensity Order Pattern (MIOP) was proposed. First, the Difference of Gaussian (DOP) regions of the image to be detected are extracted. Second, the regions are described using MIOP. Third, the features are matched and the false matching is removed by RANdom SAmple Consensus (RANSAC). Finally, the copy-move forgery regions are detected. Experimental results show that the proposed method not only has high accuracy on geometric transformation and illumination change, but also has high robustness on post-processing operations, such as Gaussian blur, noise and JPEG recompression.

数字图像作为现代社会的主要信息来源, 其真实性已成为一个重要研究课题。但是, 随着图像处理软件的发展, 图像篡改已经越来越容易。其中, 复制-粘贴作为常见的图像篡改手段, 即复制一个或多个区域, 在进行旋转、缩放、光照变换等操作后粘贴到同幅图像, 以达到增加或掩盖目标的目的。

目前复制-粘贴篡改盲检测算法的基本流程大致可分为3步:①图像重叠分块或特征点提取; ②图像块或特征点进行特征描述; ③特征描述符匹配并滤除误匹配。

基于图像重叠分块的复制-粘贴检测算法, 如离散余弦变换(Discrete cosine transform, DCT)[1], 主成分分析(Principal component analysis, PCA)[2], 傅里叶-梅林变换(Fourier-Mellin transform, FMT)[3], Hu不变矩[4]、blur不变矩[5]、Zernike矩[6]和Dense-Field[7]等, 对区域平滑的篡改图像检测率较高, 旋转和缩放等几何变换鲁棒性较差, 而且对光照变换的复制-粘贴篡改完全束手无策。

基于图像特征点提取的复制-粘贴盲检测算法, 如SIFT[8], SURF[9], Daisy[10], ORB[11]等, 该类算法对旋转和缩放等几何变换检测率较高, 但是对光照变换的鲁棒性较差。

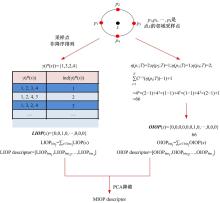

图像特征区域提取不受传感器获取图像时的视角、相机参数变化等的影响, 对旋转、缩放等几何变换有较好的鲁棒性。混合灰度序模式(Mixed intensity order pattern, MIOP)是全局灰度序信息(Overall intensity order pattern, OIOP)和局部灰度序信息(Local intensity order pattern, LIOP)的融合, 在局部特征计算中使用了与方向无关的采样策略, 因此, 具有几何旋转不变性, 并且对光照变换具有较好的鲁棒性[12]。基于此, 本文提出基于高斯差分(Different of Gaussians, DOG)区域[13]和混合灰度序模式的复制-粘贴篡改盲检测算法。

图像区域检测是图像特征提取的重要方式, 即提取图像区域后进行特征描述。由于特征点在其尺度上的自相关矩阵可以近似刻画局部区域形状, 因此, 提取的图像区域具有尺度不变性。

设图像I(x, y)的高斯尺度空间为L(x, y; σ ), σ 为高斯平滑因子(初始

式中:σ i 为特征点所在的尺度; Lx 和Ly 分别为尺度空间L(x, y; σ i)在x和y方向上的微分。

针对复杂光照变化下的复制-粘贴篡改特征较难匹配的问题, 本文采用Fan提出的基于全局灰度序信息OIOP和局部灰度序信息LIOP的混合灰度序模式MIOP特征描述方法[12]。LIOP和OIOP分别描述了特征点局部区域内每个像素点周围采样点的局部和全局灰度序列信息, 则MIOP的融合, 显著的提高了描述子的性能。

首先将图像块按灰度值排序, 并将所有灰度范围划分为

(1)LIOP特征描述符提取

将P(x)进行非降序排列, γ (P(x))为排列后的索引序列。设数组{1, 2, …, n}全排序是ind, LIOP(x)为第ind(γ (P(x)))个元素为1, 其余元素都为0的n!维的特征向量, 点x的LIOP特征

(2)OIOP特征描述符提取

首先将图像块中像素点量化为Q个级别, 设阈值集合T={t1, t2, …, tQ-1}, 则:

式中:I(Pi)为采样点Pi的灰度值。

(3)MIOP的特征描述符提取

MIOP特征是LIOP和OIOP特征的融合, LIOP的特征维数为

特征匹配中, 欧几里德距离常用来描述特征的相似性。设DOG区域

式中:

由于目前复制-粘贴图像库中不包含光照变换篡改操作, 本文选择Amerini提出的MICC-F2000图像库[8]中100幅原始真实图像和100幅复制-粘贴篡改图像, 并添加粘贴区域的光照变换篡改操作。本实验的硬件环境为:主频2.60 GHz, Intel Celeron E3400处理器, 3 G内存; 软件环境为:Windows 7+Matlab R2012b+Visual Studio 2015+Opencv 3.0.0。

为了综合性地度量算法, 本文使用Cozzolino采用F1-measure[7], 如式(6)所示:

式中:TP(True positive)是被正确检测为篡改图像的数目; FP(False positive)是被检测为篡改图像的真实图像的数目; FN(False negative)为被检测为真实图像的篡改图像的数目。F1值越大, 算法性能越好。

2.2.1 光照变换篡改实验

(1)线性光照变换

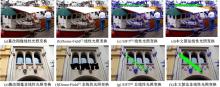

该节对图像库中篡改图像的粘贴区域分别添加两组不同程度的线性平行光, 生成200幅光照线性变换的篡改图像。Dense-Field[7], SIFT[8]和本文算法检测结果示例如图2(a~d)所示。

(2)非线性光照变换

该节对图像库中篡改图像的粘贴区域添加不同程度的非线性点光源, 生成100幅光照线性变换的篡改图像。Dense-Field[7], SIFT[8]和本文算法检测结果示例如图2(e~f)所示。

由图2实验结果可知, 本文算法较SIFT[8]能更精确地匹配复制-粘贴篡改区域, 而Dense-Field[7]则完全不能定位篡改区域。

2.2.2 几何变换篡改实验

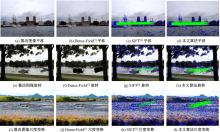

该节对图像库中篡改图像的粘贴区域进行不同大小的旋转和尺度变换, 共生成200+200幅几何变换的篡改图像。Dense-Field[7], SIFT[8]和本文算法检测结果示例如图3所示。

由实验结果可知, 本文算法, SIFT[8]和Dense-Field[7]在简单平移的复制-粘贴篡改中都表现较好, 在篡改区域旋转和尺度变换后, 本文算法更能匹配正确的特征点, SIFT[8]特征点匹配明显减少, 而Dense-Field[7]在尺度变换性能较差。

2.2.3 光照和几何变换混合篡改实验

为了综合验证本文算法性能, 该节对图像库中篡改图像的粘贴区域进行混合操作, 共生成200幅混合操作篡改图像。Dense-Field[7], SIFT[8]和本文算法检测结果示例如图4所示。

由实验结果可知, SIFT[8]匹配的特征点过少, Dense-Field[7]在光照变换的条件下完全束手无策, 只有本文算法能准确定位复制-粘贴篡改区域。

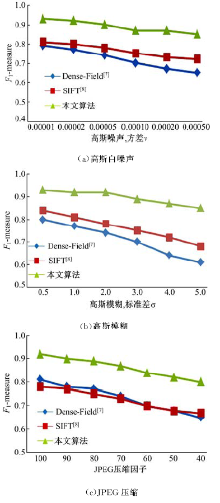

2.2.4 后处理操作鲁棒性实验

图像在传输过程中受到噪声、模糊、压缩等后处理操作影响, 增加了复制-粘贴算法的难度。因此, 检测算法对后处理操作的鲁棒性, 是衡量其性能的重要指标。

本节对数据库中图像分别添加:①高斯白噪声:利用Matlab函数imnoise, 其参数设为均值m=0, 方差v=[0.00001, 0.00002, 0.00005, 0.0001, 0.0002, 0.0005]; ②高斯模糊:利用Matlab函数imfilter添加与高斯模糊, 其窗口尺寸w=3, 标准差σ =[0.5, 1, 2, 3, 4, 5]; ③JPEG压缩:压缩因子从100至40, 以-10为间隔。Dense-Field[7], SIFT[8]和本文算法F1-measure曲线如图5所示。

2.2.5 算法有效性实验

为了验证算法针对纹理信息丰富, 篡改区域与周围背景差异不明显的复制-粘贴篡改的有效性, 本节选择MICC-F2000图像库[8]中10幅真实和其篡改图像进行实验。本文算法检测结果示例如图6所示。

针对目前复制-粘贴篡改盲检测算法对光照变换操作鲁棒性较差的问题, 本文提出了一种基于DOG区域和MIOP的复制-粘贴盲鉴别算法。通过实验证明, 本文算法与Dense-Field[7], SIFT[8]相比, 不仅对几何和光照变换的篡改图像检测率较高, 并对模糊、噪声和JPEG重压缩等后处理操作有较好的鲁棒性。

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|