作者简介:潘海阳(1977-),男,博士研究生.研究方向:导航,制导与控制.E-mail:sea.climb@gmail.com

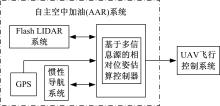

在分析自主空中加油技术典型解决方案的基础上,提出了基于三维快速成像激光雷达(3D flash LIDAR)的自主空中加油技术方案。该方案可以在很大程度上减少或消除自主空中加油对GPS的依赖,为合理利用非相似余度导航定位功能提供可靠的技术支撑。首先根据加、受油机空中加油编队飞行特点,确定了以平尾和垂尾为特征平面的加油机点云深度信息特征提取方案和算法。其次利用拉格朗日乘法求取点云子集的最佳拟合平面的单位法向量,为视觉里程计估算加油机相对受油机位姿变化提供了信息。仿真结果表明,特征提取和位姿估算算法可行。同时为了提高视觉里程计对相对位姿估算的准确性,利用矢量中值滤波、平尾与垂尾相关性来消除测量和数据处理中产生的误差,仿真结果表明:在白噪声信噪比为25 dB时,滤波算法可行。

Based on the analysis of the Autonomous Aerial Refueling (AAR) technology, a Flash LIDAR-based AAR scheme was proposed. This scheme can reduce or eliminate the dependence on GPS for AAR. First, according to the flight formation characteristics of the tanker and receiver aircraft, the horizontal and vertical tail of the tanker was selected as the characteristic plane, and a feature extraction algorithm for the tanker's point cloud subset was worked out. Second, Lagrange multiplier method was employed to calculate the unit normal vector of the best fitting characteristic-plane. The unit normal vectors of the successive point cloud frames were available data for visual odometry to estimate the relative pose change between the tanker and receiver aircraft. Simulations show that the feature extraction and pose estimation algorithm is feasible. Finally, in order to improve the accuracy of relative pose estimation of visual odometry, vector median filtering, horizontal and vertical tail correlation algorithm were employed to eliminate measurement errors. Results show that the filter algorithm is feasible in the condition of white noise SNR 25 dB.

无人机自主空中加油(AAR)技术是实现无人机远程战略任务的核心技术之一。美国国防部先进研究项目局近日完成了两架改进型RQ-4“全球鹰”无人机的近距编队飞行测试工作,对该型无人机的空中自主互助加油技术进行了成功验证,使其续航时间从之前的41 h延长至160 h以上[ 1]。

针对飞桁式空中加油机,研究者采用差分GPS对其进行编队控制,计算得出二者相对位置误差不超过0.1 m[ 2]。美国国防部先进研究项目局和美国国家航空航天局联合研究了一种针对软管-浮锚式空中加油机的GPS、惯性传感器和视觉传感器组合控制的自主空中加油技术,并且在波音707/300和F/A-18上成功地进行了试验[ 3]。上述自动空中加油方式是基于GPS技术完成的,当GPS信号降级、失效或受到干扰时不可避免地会影响任务的完成。为此,美空军自主空中加油(AAR)项目开始致力于找到一种稳定、准确的自主空中加油控制方式。文献[4]针对软管-浮锚式空中加油机,采用基于视觉传感器和导航系统,利用安装在加油伞上的红外LED与受油机上的光学传感器相配合,来确定二者的相对距离和方位。文献[5]针对飞桁式空中加油机,利用单目摄像机和机上惯性导航系统来消除对GPS的依赖。但是,在上述方法中,不是要在加油机上加改装红外设备,就是容易受到天气等外界因素的影响。最近,三维快速成像LIDAR(3D Flash LIDAR)的出现为无人机自主空中加油提供了一个值得信赖的技术途径。文献[6]对Flash LIDAR应用在软管-浮锚式空中加油机自主空中加油的最终对接过程进行了研究,描述了Flash LIDAR提供的深度图像信息具有良好的实时空间转换特性,在物体高速运动时也不会造成被转换图像的模糊。这些特性可大大简化对接过程中目标辨识的算法。但是文献[6]只涉及了对接过程的研究,而空中加油通常包括:编队、对接、加油及脱开4个阶段。本文将讨论基于Flash LIDAR的自主空中加油编队过程中加油机深度图像特征提取及跟踪,以及视觉里程计技术在编队过程中的应用。

Flash LIDAR采用的是飞时测距(Time of flight,ToF)三维成像,与通常的商用ToF照相机通过计算入射光与反射光相对相移关系来求取距离信息不同,它采用的是直接脉冲飞时测距,该测量方式最远测量距离是相移式测量的50倍左右,并且测量距离的精度仅由脉冲激光的往返时间 t决定,因此该方式可精确测量两个高速运动物体的相对距离[ 7]。其测距单元原理图如 图1所示[ 8]。

Flash LIDAR的测量单元是组合型三维焦平面阵列(Focal plane array,FPA),该阵列将固态光电检测阵列与读数计算集成电路键合在一起。读数计算集成电路中的每个单元与光电检测阵列中的检测单元一一对应,这样二者就组成了一个测量通道。测量通道的数量由FPA的像素决定,也就是FPA中的每个像素都能够独立地通过接收Flash LIDAR向物体连续发送光脉冲的反射光,通过记录光脉冲的飞行(往返)时间来计算得出目标物距离,并以( x, y, z)数据格式来记录三维空间信息。目前FPA最高可达到512×512像素。由此可见,只需对该测距单元所记录的每帧图像进行简单的计算便可得到相应的深度图像信息,其采样频率最高可达30帧/s,此特性对实时性要求较高的场合尤为重要。

图2下方是Flash LIDAR采集的上方飞机1帧内的点云图像,点云的颜色是按深度图像信息随机分配的。

此外,Flash LIDAR在低能见度条件下也具有良好的工作性能。美国国家航空航天局自动着陆及危险规避技术(ALHAT)项目已经开始在AS-325直升机上进行了基于Flash LIDAR的自动着陆系统动态测试[ 9]。

综上所述,只要在受油机上加装Flash LIDAR,便能够实时、可靠地获取空中加油机与受油机之间的空间相对位置深度图像信息,这将在很大程度上减少或消除自主空中加油对GPS的依赖,为合理利用非相似余度导航定位功能提供可靠的技术支撑。

基于三维点云图像、INS和GPS的自主空中加油原理如 图3所示。在无人机自主空中加油的过程中,加油机和受油机(即无人机)之间的相对位姿估计是否精确是决定空中加油成败的关键性因素[ 10]。为此,在系统中增加了一种非相似余度光学传感器Flash LIDAR来测量二者相对距离和姿态。Flash LIDAR输出的3D点云在图像处理后,可经过卡尔曼滤波等多传感器信息融合算法来提高AAR系统的可靠性和容错性。由于文献[11-13]对卡尔曼滤波器的应用做了较详细的阐述,本文就只对Flash LIDAR的测量、信号处理和位姿估计等问题进行研究。

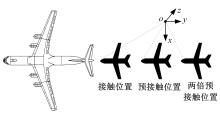

受油机准确估计加油机的相对位姿的变化是自主空中加油的关键问题。因此必须首先对二者编队飞行的情况进行研究,以确定合理的加油机图像特征提取方案,并在确保位姿估计准确性的前提下提高信号处理效率。 图4为空中加油编队示意图。

图5[ 14]为在虚拟现实环境下生成的受油机在预对接位置时观测到的加油机图像信息。该图与Flash LIDAR输出的图像信息的主要区别在于其无法提供深度信息。但是依然可以从平尾、垂尾和机翼等部位提取出近似于平面的形状特征。

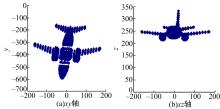

在加油机深度图像特征提取中,具有平面特征的平尾和垂尾无疑具有良好的特征提取特性,且二者夹角固定不变,这些都将为接下来的定位和导航提供实时可靠的信息源。由于加油机的平尾和垂尾在机上的绝对位置和二者之间的相对位置信息能够预先获取,因此可根据点云的 xy和 xz轴坐标图(见 图6)将其分割为几个子集。

该点云集是737-400飞机3D max模型的WRL格式文件在Imageware软件环境下模拟生成的点云在Excel图表中的显示, 图6(a)为受油机视角下 xy轴坐标图; 图6(b)为受油机视角下 xz轴坐标图,图中受油机与加油机 y轴之间存在一定夹角,随着角度的增加,垂尾上可见点云数量也随之增加。平尾和垂尾的点云子集分别可表示为:

式中: Zs为点云子集; Xi为在垂尾或平尾范围内的点的三维坐标。

可以根据 Zs中的点云来确定平面的法向量:

式中: N为平面在直角坐标系上的单位法向量,可以表示为:

P0为平面上的参考点,由于平尾或垂尾近似于一个平面, P0取子集内所有点的平均值:

由于子集内每个点不可能都在一个理想的平面内,为了获得最佳拟合平面就要使各点到平面的和方差 esse最小,可表示为:

由于单位法向量 N的内积为1,式(5)可表示为:

利用拉格朗日乘法计算 esse的最小值,对式(6)分别求 nx, ny, nz的偏导,可表示为:

可将式(7a)~(7c)表示为:

由此可得点云子集 Zs中元素协方差矩阵的特征向量就是最佳拟合平面单位法向量。利用单位法向量的内积为1的性质将式(8)简化为:

由于要使得 esse最小,因此 λmin所对应的特征向量为最佳拟合平面单位法向量 N。

视觉里程计(Visual odometry)是通过分析载体上光学传感器提供的图像信息来确定其方位的过程。随着信息科学的不断发展,该技术已在各类组合导航定位中得到广泛运用。例如在美国国家航空航天局“火星探测漫游者”计划最开始的两年中,视觉里程计就逐渐发展成为一个至关重要的探测车安全系统[ 15]。

在研究自主空中加油编队飞行问题中,为了便于估算受油机与加油机之间的相对位姿,将二者放在同一个坐标系内,如 图3所示。坐标系采用ISO体系,Flash LIDAR在受油机上的安装位置定义为坐标原点。这样就可以将估算加、受油机之间的相对位姿变化问题转化成根据点云的深度信息来估算加油机在坐标系内旋转和平移的问题。

在经过特征图像提取后,加油机的旋转和平移又可以简化为平尾和垂尾在坐标系下位姿变化的估算,可表示为:

式中: Fi、 Fi+1为Flash LIDAR采集的连续两帧深度图像提取出的特征平面; R为旋转矩阵,其转动次序为绕 oy轴转动角度 φ、绕 ox轴转动角度 θ和绕 oz轴转动角度 ψ,可表示为:

式中: θ、 φ和 ψ分别为加油机相对受油机的俯仰、滚转和偏航角; T为特征平面在坐标系内的平移量,可表示为:

根据式(2)~(4)和式(10)~(12)可将加油机相对姿态变化表示为:

相对位置变化表示为:

式中: Ni+1、 Ni和

在Flash LIDAR测量和处理过程中由于测量中的随机噪声、测量位置和边缘噪声等因素的影响[ 16],不可避免地会造成测量误差。这些误差都将传递至后期的加油机相对位姿估计,影响估计的准确性。

为了消除随机噪声的干扰,首先对点云子集 Zs中的元素进行3×3矢量中值滤波,相邻9点的中心点 X22取9点中相互间距离最近点的值:

但是上述方法对消除由于边缘噪声引起的干扰效果不好,为此对矢量中值滤波后数据要进行跳变边缘滤波。为了剔除平尾和垂尾周围的干扰信息,构造平面边缘滤波器,可表示为:

式中: D为 Xnm和 Xn, m+1两个相邻点之间的距离; C为 Xnm和 Xn, m+1两个相邻点之间的接近程度,当二者在坐标系内完全重合时, C=1,当相互垂直时, C=0。当 δ小于设定阈值 δt时,则认定对应的点 Xn, m+1处于平面 S之内。

在消除了随机噪声和边缘噪声的影响后,根据式(4)可知,子集内所有点的平均值 P0也会影响到位姿估计的准确性。由于平尾面积较大,因此以该平面参数为主来估算位姿。但是当平尾没有完全被包括在Flash LIDAR的视野中时, P0中

综上所述,点云深度信息的准确性是影响位姿估算的关键因素。在经过矢量中值滤波、平面边缘滤波和平尾与垂尾相关性处理之后,可与惯性导航、GPS和大气数据系统的信息进行融合来提高位姿估计精度。

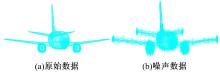

为了验证加油机图像特征提取和相对位姿估算方法的处理效果,以3D Max环境下生成的原始点云数据并加入白噪声干扰来模拟Flash LIDAR的测量误差和边缘噪声。加入干扰前、后的点云数据在Imageware软件环境下的多边形网格显示如 图7所示。该原始数据格式和点云数量与Flash LIDAR采集的点云数据格式相同,数量相近,而且模拟的是全部包括垂尾和平尾的情况,因此该原始数据可用于验证位姿估计算法的有效性。

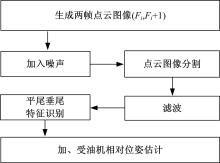

首先模拟加油机运动轨迹,在3D Max环境下设置加油机模型的不同位姿,并生成两帧点云数据,为位姿估算提供原始数据,接下来对点云数据人工加入白噪声干扰、点云分割,然后进行滤波、特征提取和位姿估算等处理,流程如 图8所示。

生成的两帧点云数据为加油机相对于受油机(三维坐标原点和 xyz轴)的位姿,如 表1所示。

| 表1 初始点云数据位姿参数 Table 1 Position and rotation parameters of the point cloud generated |

表1中, tx、 ty和 tz为加油机相对于受油机的平移量; θ、 φ和 ψ分别为加油机相对于受油机的俯仰、滚转和偏航角。

对生成的初始点云数据以及在此基础上加入信噪比为25 dB白噪声的两帧点云数据进行数据处理,计算加油机相对受油机的位姿变化,以验证上述平面滤波、特征提取和相对位姿估算算法的可行性和准确性,其中利用平尾的深度信息来估算 Δθ和 Δφ,利用垂尾的深度信息来估算 Δψ。其估算结果如 表2所示。

| 表2 点云数据位姿参数估算 Table 2 Position and rotation parameters estimation |

由 表2可以得出:垂尾和平尾的特征提取以及法向量计算算法可靠,姿态估算效果良好,说明滤波器能够消除随机噪声等干扰。由于 ty分量较大,垂尾和平尾为非完美平面以及两帧深度图像提取出的特征平面匹配问题造成的

(1)提出了基于三维点云图像深度信息的无人机自主空中加油方案,该方案利用Flash LIDAR采集到的深度信息,为自主空中加油系统提供一种非相似余度位姿估算通道。

(2)提出了对加油机深度图像信息特征提取和处理的方法,通过视觉里程计技术估算加、受油机间相对位姿变化,经仿真验证该方法可行。

(3)根据Flash LIDAR的测量原理提出了消除误差的数据处理方法,经仿真验证该方法可行。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|