吉林大学学报(工学版) ›› 2019, Vol. 49 ›› Issue (4): 1026-1033.doi: 10.13229/j.cnki.jdxbgxb20180467

• • 上一篇

基于多类型传感数据的自动驾驶深度强化学习方法

- 吉林大学 汽车仿真与控制国家重点实验室,长春 130022

Autonomous driving policy learning based on deep reinforcement learning and multi⁃type sensor data

Shun YANG( ),Yuan⁃de JIANG,Jian WU(

),Yuan⁃de JIANG,Jian WU( ),Hai⁃zhen LIU

),Hai⁃zhen LIU

- State Key Laboratory of Automotive Simulation and Control, Jilin University, Changchun 130022, China

摘要:

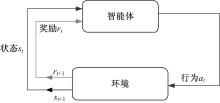

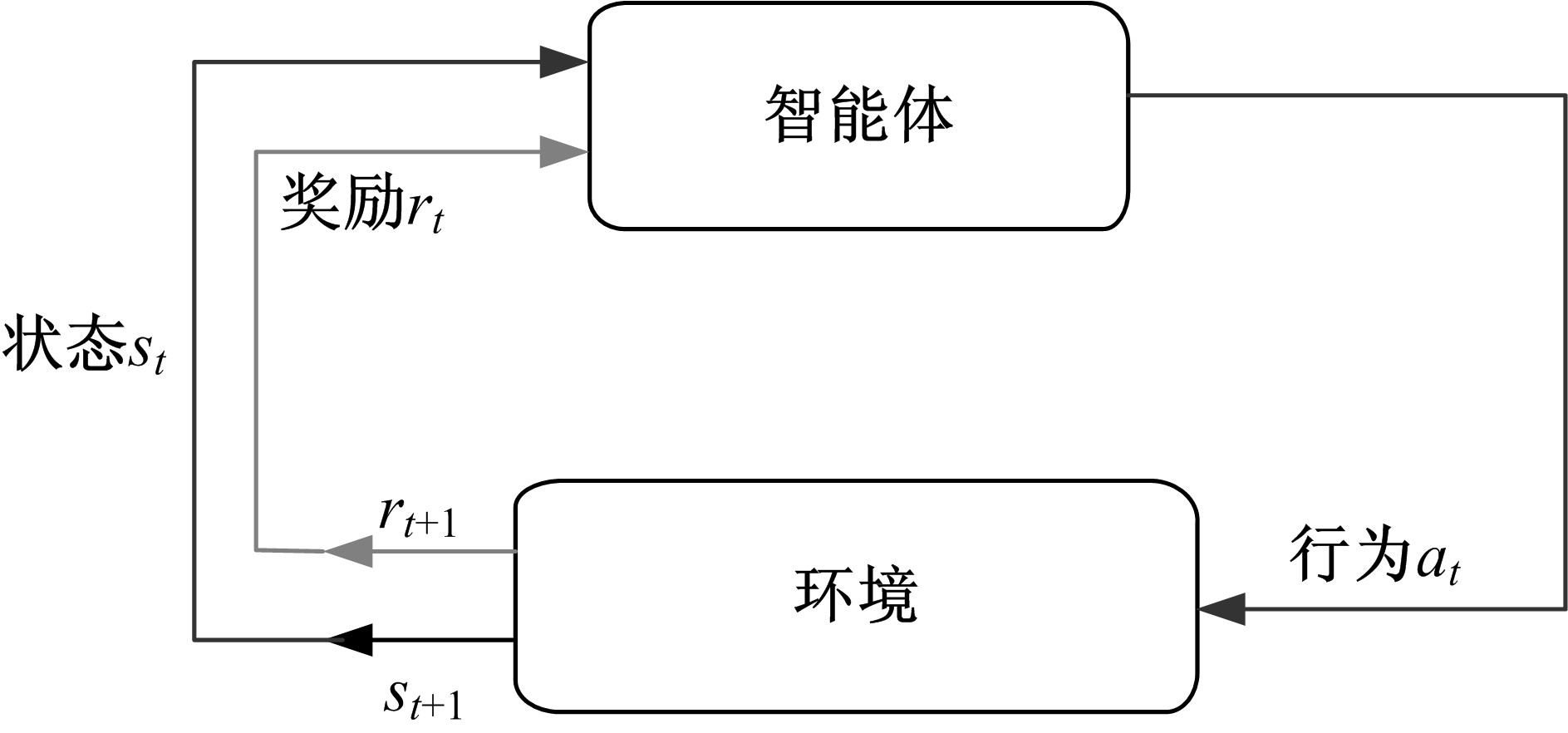

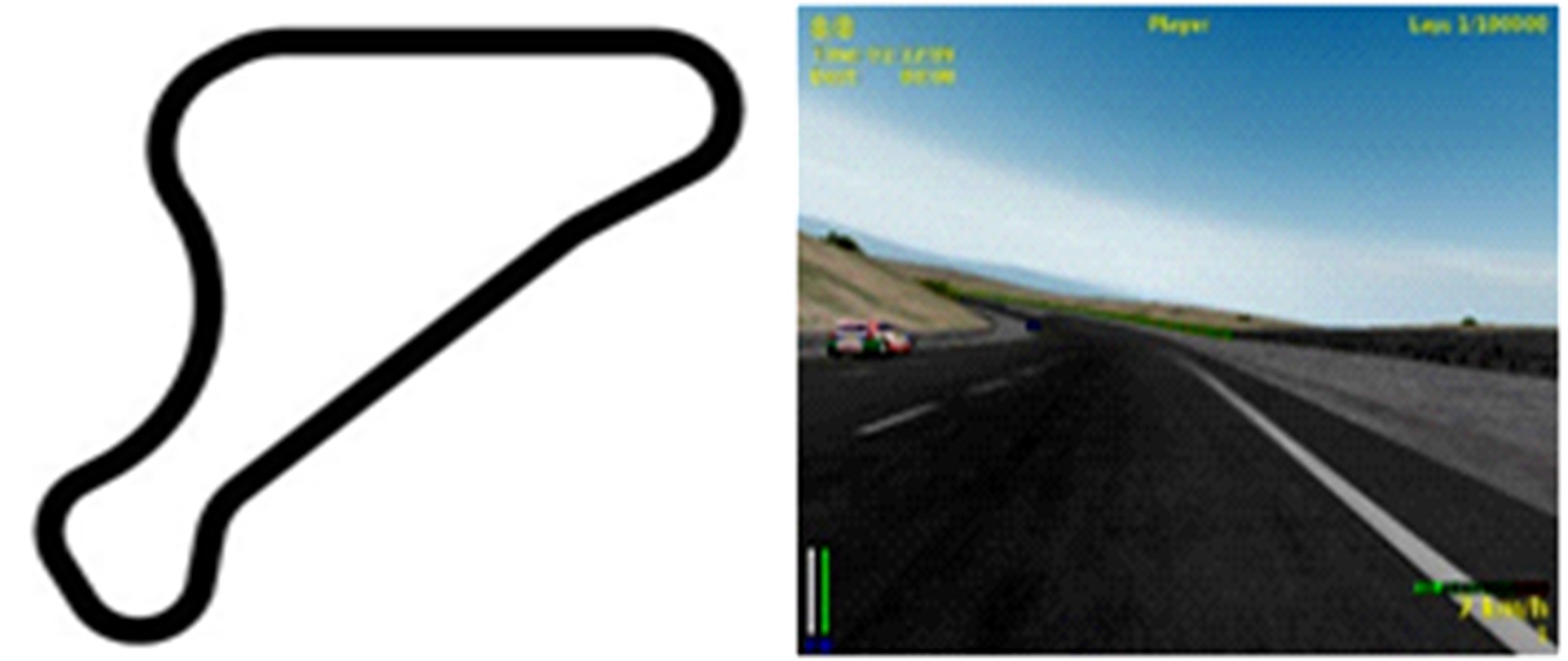

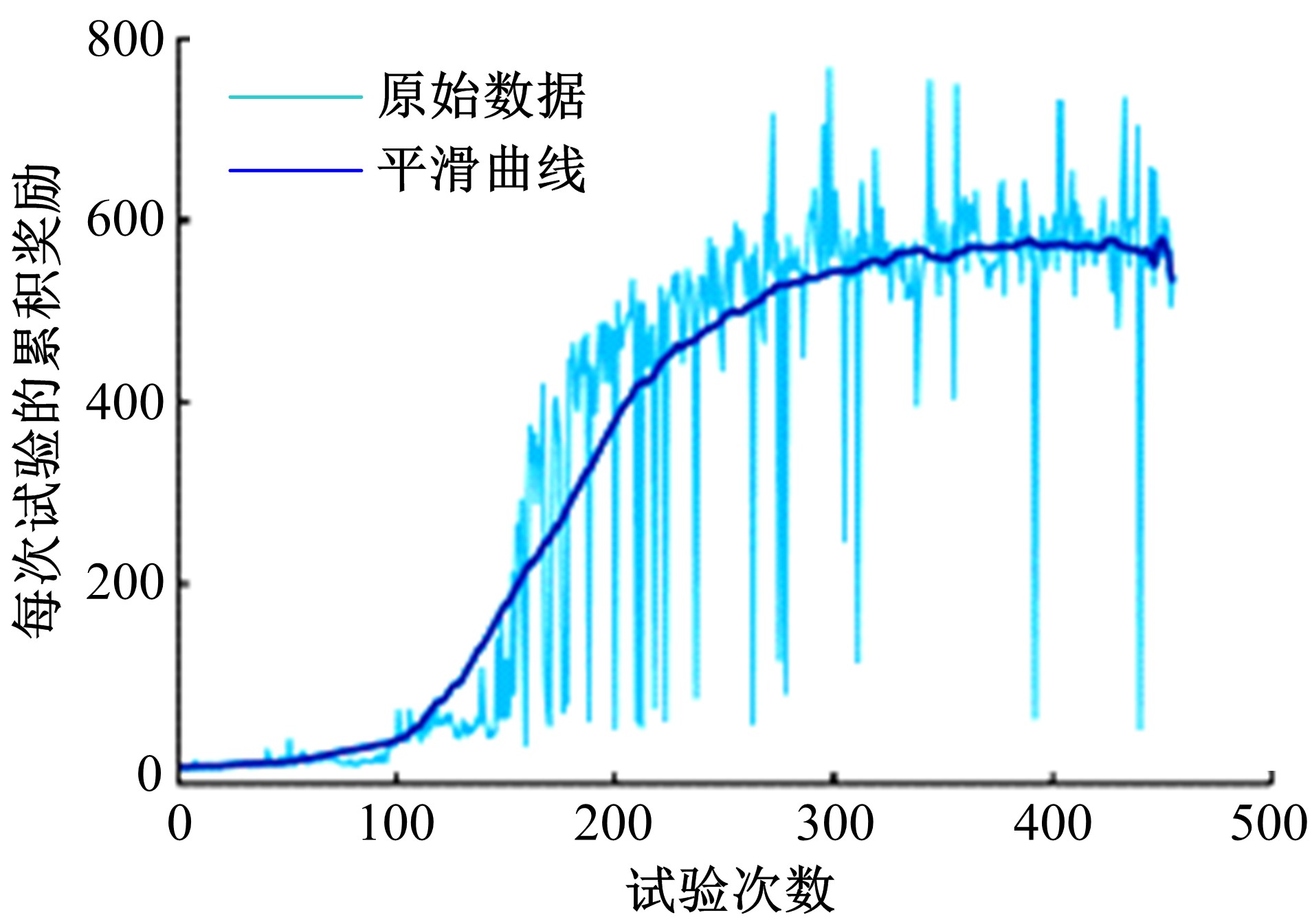

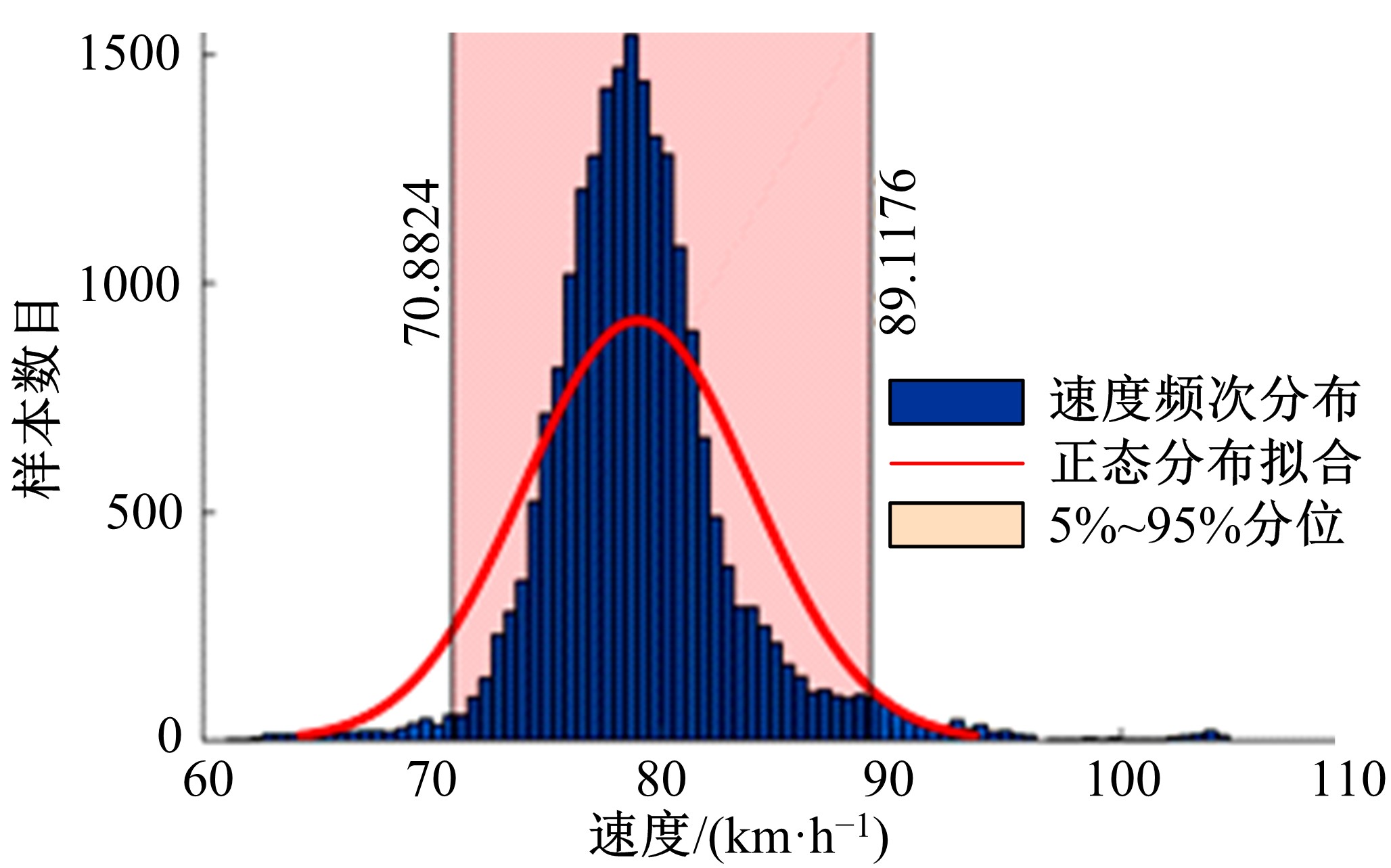

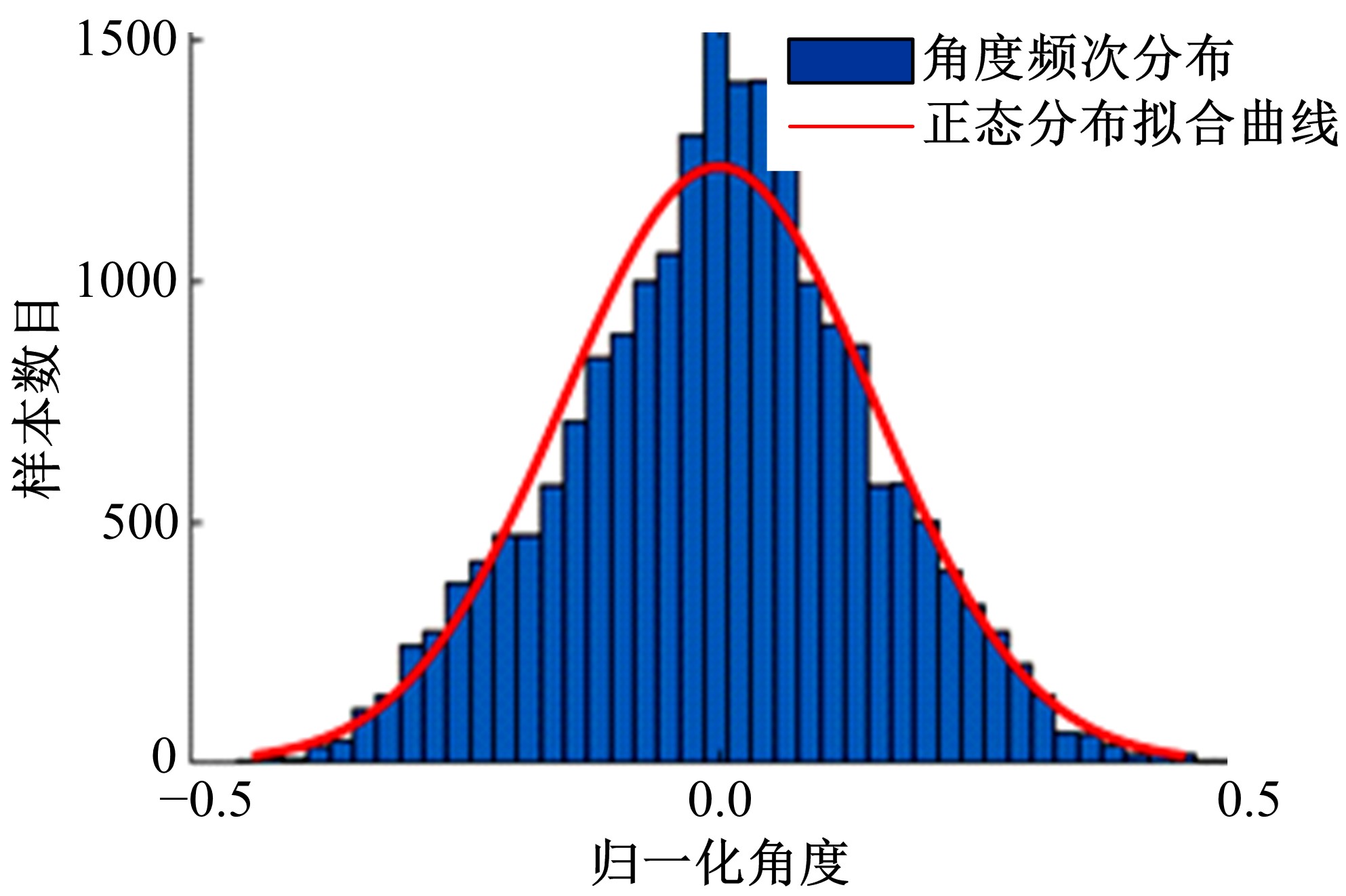

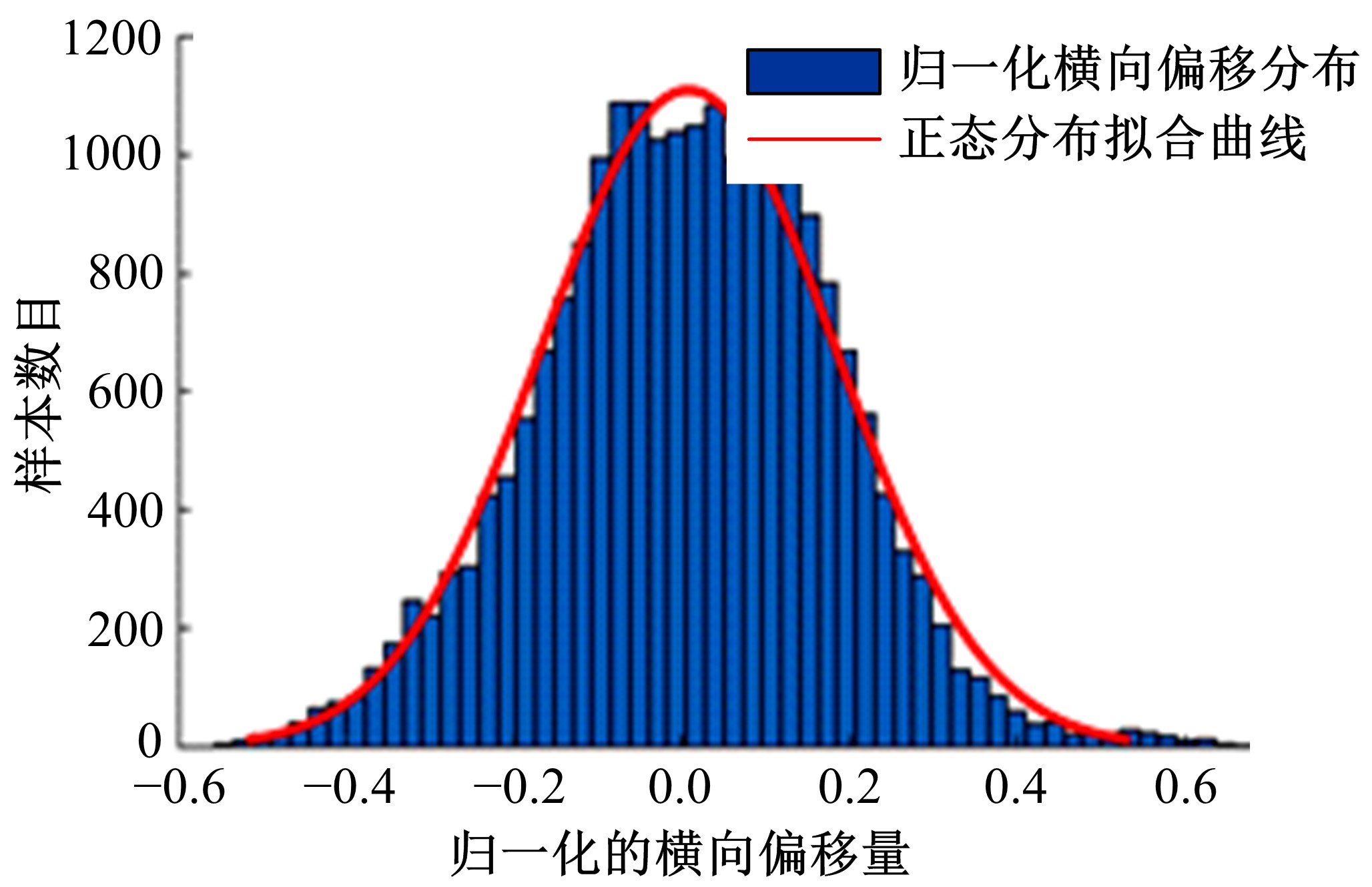

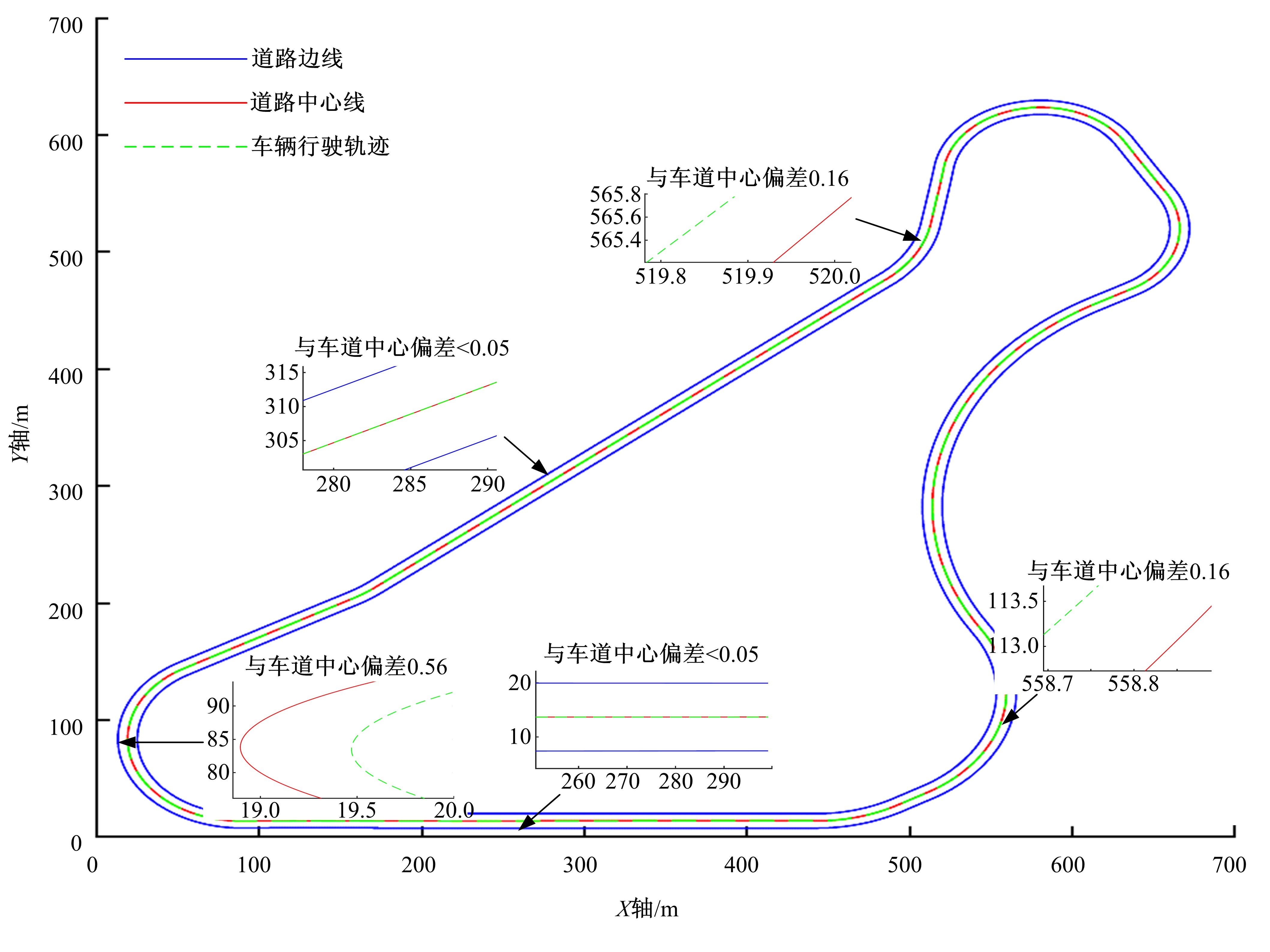

提出了一种基于多类型传感数据训练自动驾驶策略的方法,采用不同卷积网络对高维图像数据和低维目标级传感数据进行特征提取,然后对提取特征进行组合,采用组合特征学习自动驾驶策略。在仿真测试软件TORCS中设计车道跟随任务对本文方法进行验证,结果表明:基于多类型传感信息进行深度强化训练可以取得较好的车速和车辆横向偏移控制效果。

中图分类号:

- U469.79

| 1 | Kohl N , Stone P . Policy gradient reinforcement learning for fast quadrupedal locomotion[C]∥IEEE International Conference on Robotics and Automation, New Orleans, LA, USA, 2004:2619⁃2624. |

| 2 | 南杨, 李中健, 叶文伟 . 基于强化学习的飞行自动驾驶仪设计[J]. 电子设计工程, 2013, 21(10):45⁃47. |

| Nan Yang, Li Zhong⁃jian , Ye Wen⁃wei .Design of autopilot for aircraft based on reinforcement learning[J]. Electronic Design Engineering, 2013, 21(10): 45⁃47. | |

| 3 | Hwangbo J , Sa I , Siegwart R , et al . Control of a quadrotor with Reinforcement Learning[J]. IEEE Robotics & Automation Letters, 2017, 2(4):2096⁃2103. |

| 4 | Xiong R , Cao J , Yu Q . Reinforcement learning⁃based real⁃time power management for hybrid energy storage system in the plug⁃in hybrid electric vehicle[J]. Applied Energy, 2018, 211:538⁃548. |

| 5 | Strehl A L , Li L , Wiewiora E , et al . PAC model⁃free reinforcement learning[C]∥ACM International Conference on Machine Learning, Pittsburgh, USA,2006:881⁃888. |

| 6 | Lecun Y , Bengio Y , Hinton G . Deep learning[J]. Nature, 2015, 521(7553):436. |

| 7 | Mnih V , Kavukcuoglu K , Silver D , et al . Playing atari with deep reinforcement learning[DB/OL].[ 2013⁃12⁃16]. https:∥arxiv.org/archive/csarXiv:1312.5602. |

| 8 | Silver D , Huang A , Maddison C J , et al . Mastering the game of go with deep neural networks and tree search[J]. Nature, 2016, 529(7587):484⁃489. |

| 9 | Sallab A E , Abdou M , Perot E , et al . End⁃to⁃end deep reinforcement learning for lane keeping assist[C]∥The 30th Conference on Neural Information Processing Systems, Barcelona, Spain, 2016. |

| 10 | Chae H , Kang C M , Kim B D , et al . Autonomous braking system via deep reinforcement learning[C]∥IEEE International Conference on Intelligent Transportation Systems, Maui, Hawaii, USA, 2017:1⁃6. |

| 11 | 夏伟, 李慧云 . 基于深度强化学习的自动驾驶策略学习方法[J]. 集成技术, 2017, 6(3):29⁃40. |

| Xia Wei , Li Hui⁃yun . Training method of automatic driving strategy based on deep reinforcement learning[J]. Journal of Integration Technology, 2017, 6(3):29⁃40. | |

| 12 | Nazari M , Oroojlooy A , Snyder L V , et al . Reinforcement learning for solving the vehicle routing problem[C]∥The 35th International Conference on Machine Learning, Stockholm, Sweden,2018. |

| 13 | Sutton R S , Barto A G . Reinforcement Learning: an introduction, bradford book[J]. Machine Learning, 2005, 16(1):285⁃286. |

| 14 | Lin L J . Reinforcement learning for robots using neural networks[D]. Pittsburgh: Carnegie Mellon University, 1993. |

| 15 | Loiacono D , Cardamone L , Lanzi P L . Simulated car racing championship: competition software manual[DB/OL]. [ 2013⁃11⁃22]. https:∥arxiv.org/archive/csarXiv:1304.1672. |

| [1] | 李静,石求军,刘鹏,户亚威. 基于纵向车速估算的商用车ABS神经网络滑模控制[J]. 吉林大学学报(工学版), 2019, 49(4): 1017-1025. |

| [2] | 常成,宋传学,张雅歌,邵玉龙,周放. 双馈电机驱动电动汽车变频器容量最小化[J]. 吉林大学学报(工学版), 2018, 48(6): 1629-1635. |

| [3] | 席利贺,张欣,孙传扬,王泽兴,姜涛. 增程式电动汽车自适应能量管理策略[J]. 吉林大学学报(工学版), 2018, 48(6): 1636-1644. |

| [4] | 何仁,杨柳,胡东海. 冷藏运输车太阳能辅助供电制冷系统设计及分析[J]. 吉林大学学报(工学版), 2018, 48(6): 1645-1652. |

| [5] | 那景新,慕文龙,范以撒,谭伟,杨佳宙. 车身钢-铝粘接接头湿热老化性能[J]. 吉林大学学报(工学版), 2018, 48(6): 1653-1660. |

| [6] | 刘玉梅,刘丽,曹晓宁,熊明烨,庄娇娇. 转向架动态模拟试验台避撞模型的构建[J]. 吉林大学学报(工学版), 2018, 48(6): 1661-1668. |

| [7] | 赵伟强, 高恪, 王文彬. 基于电液耦合转向系统的商用车防失稳控制[J]. 吉林大学学报(工学版), 2018, 48(5): 1305-1312. |

| [8] | 宋大凤, 吴西涛, 曾小华, 杨南南, 李文远. 基于理论油耗模型的轻混重卡全生命周期成本分析[J]. 吉林大学学报(工学版), 2018, 48(5): 1313-1323. |

| [9] | 朱剑峰, 张君媛, 陈潇凯, 洪光辉, 宋正超, 曹杰. 基于座椅拉拽安全性能的车身结构改进设计[J]. 吉林大学学报(工学版), 2018, 48(5): 1324-1330. |

| [10] | 那景新, 浦磊鑫, 范以撒, 沈传亮. 湿热环境对Sikaflex-265铝合金粘接接头失效强度的影响[J]. 吉林大学学报(工学版), 2018, 48(5): 1331-1338. |

| [11] | 王炎, 高青, 王国华, 张天时, 苑盟. 混流集成式电池组热管理温均特性增效仿真[J]. 吉林大学学报(工学版), 2018, 48(5): 1339-1348. |

| [12] | 金立生, 谢宪毅, 高琳琳, 郭柏苍. 基于二次规划的分布式电动汽车稳定性控制[J]. 吉林大学学报(工学版), 2018, 48(5): 1349-1359. |

| [13] | 隗海林, 包翠竹, 李洪雪, 李明达. 基于最小二乘支持向量机的怠速时间预测[J]. 吉林大学学报(工学版), 2018, 48(5): 1360-1365. |

| [14] | 王德军, 魏薇郦, 鲍亚新. 考虑侧风干扰的电子稳定控制系统执行器故障诊断[J]. 吉林大学学报(工学版), 2018, 48(5): 1548-1555. |

| [15] | 胡满江, 罗禹贡, 陈龙, 李克强. 基于纵向频响特性的整车质量估计[J]. 吉林大学学报(工学版), 2018, 48(4): 977-983. |

|

||